[2307.02046] Recommender Systems in the Era of Large Language Models (LLMs) (arxiv.org)

Recommender Systems in the Era of Large Language Models (LLMs)

With the prosperity of e-commerce and web applications, Recommender Systems (RecSys) have become an important component of our daily life, providing personalized suggestions that cater to user preferences. While Deep Neural Networks (DNNs) have made signif

arxiv.org

추상적인

전자 상거래 및 웹 애플리케이션의 번영과 함께 추천 시스템(RecSys)은 일상 생활에서 없어서는 안 될 중요한 구성 요소가 되었으며 사용자 선호도에 맞는 개인화된 제안을 제공합니다. 심층 신경망(DNN)은 사용자-항목 상호 작용을 모델링하고 텍스트 사이드 정보를 통합하여 추천 시스템을 향상시키는 데 상당한 발전을 이루었지만, 이러한 DNN 기반 방법은 여전히 사용자의 관심사를 효과적으로 이해하고 텍스트 사이드 정보를 캡처하는 데 어려움이 있고, 다양한 보이거나 보이지 않는 추천 시나리오를 일반화하고 예측을 추론할 수 없는 등 몇 가지 한계가 있습니다. 등. 한편, ChatGPT 및 GPT-4와 같은 대규모 언어 모델(LLM)의 개발은 언어 이해 및 생성의 기본 책임에 대한 놀라운 능력과 인상적인 일반화 능력 및 추론 능력으로 인해 자연어 처리(NLP) 및 인공 지능(AI) 분야에 혁명을 일으켰습니다. 그 결과, 최근 연구에서는 LLM의 힘을 활용하여 추천 시스템을 강화하려는 시도가 활발하게 이루어지고 있습니다. 추천 시스템에서 이러한 연구 방향이 빠르게 발전함에 따라 관련 분야의 연구자와 실무자에게 심층적인 이해를 제공하기 위해 기존 LLM 기반 추천 시스템을 요약하는 체계적인 개요가 절실히 필요합니다. 따라서 이 설문조사에서는 사전 학습, 미세 조정, 프롬프트 패러다임을 포함한 다양한 측면에서 LLM 기반 추천 시스템을 포괄적으로 검토합니다. 좀 더 구체적으로 말하자면, 먼저 LLM(피처 인코더)의 힘을 활용하여 사용자와 아이템의 표현을 학습하는 대표적인 방법을 소개합니다. 그런 다음 사전 학습, 미세 조정, 프롬프트라는 세 가지 패러다임에서 추천 시스템을 향상시키기 위한 LLM의 새로운 고급 기술을 체계적으로 검토합니다. 마지막으로, 우리는 이 신흥 분야의 유망한 미래 방향에 대해 포괄적으로 논의합니다.

색인 기간: 추천 시스템, 대규모 언어 모델(LLM), 사전 학습 및 미세 조정, 프롬프트, 컨텍스트 내 학습.

1소개

추천 시스템(RecSys)은 사용자의 온라인 경험을 풍부하게 하기 위해 정보 과부하를 완화하는 데 중요한 역할을 합니다(즉, 사용자는 관심 있는 정보를 찾기 위해 압도적인 정보를 필터링해야 함). [1, 2]. 엔터테인먼트와 같은 다양한 응용 프로그램 영역에서 사용자 선호도를 충족하도록 맞춤화된 후보 항목에 대한 개인화된 제안을 제공합니다 [3], 전자 상거래 [4]및 작업 매칭 [2]. 예를 들어, 영화 추천(예를 들어, IMDB 및 넷플릭스)에서, 영화의 콘텐츠 및 사용자의 시청 이력을 기반으로 최신 영화를 사용자에게 추천할 수 있으며, 이는 사용자가 자신의 관심사에 맞는 새로운 영화를 발견하는 데 도움을 줄 수 있다. 추천 시스템의 기본 개념은 사용자와 항목 간의 상호 작용 및 관련 사이드 정보, 특히 항목 설명, 사용자 프로필 및 사용자 리뷰와 같은 텍스트 정보를 사용하여 사용자와 항목 간의 일치 점수(즉, 사용자가 항목을 좋아할 확률)를 예측하는 것입니다 [5]. 보다 구체적으로, 사용자와 항목 간의 협업 행동은 다양한 추천 모델을 설계하는 데 활용되었으며, 이는 사용자와 항목의 표현을 학습하는 데 추가로 사용될 수 있습니다 [6, 7]. 또한 사용자 및 항목의 텍스트 사이드 정보에는 일치 점수 계산에 도움이 될 수 있는 풍부한 지식이 포함되어 있어 추천 시스템을 발전시키기 위한 사용자 선호도를 이해하는 데 유용한 통찰력을 제공합니다 [8].

다양한 분야에서 표현 학습의 놀라운 능력으로 인해 DNN(Deep Neural Networks)은 추천 시스템을 발전시키기 위해 널리 채택되었습니다 [9, 10]. DNN은 다양한 아키텍처와의 사용자-항목 상호 작용을 모델링하는 고유한 기능을 보여줍니다. 예를 들어, 순차 데이터에 특히 효과적인 도구로, 사용자 상호 작용 시퀀스에서 고차 종속성을 캡처하기 위해 RNN(Recurrent Neural Networks)이 채택되었습니다 [11, 12]. 사용자의 온라인 행동(예: 병아리, 구매, 사교)을 그래프 구조화된 데이터로 간주하면 그래프 신경망(GNN)이 사용자 및 항목 표현을 학습하기 위한 고급 표현 학습 기술로 부상했습니다 [6, 1, 13]. 한편, DNN은 사이드 정보를 인코딩하는 데에도 이점이 있습니다. 예를 들어, 사용자로부터 텍스트 리뷰를 추출하고 활용하기 위해 BERT 기반 방법을 제안합니다 [14].

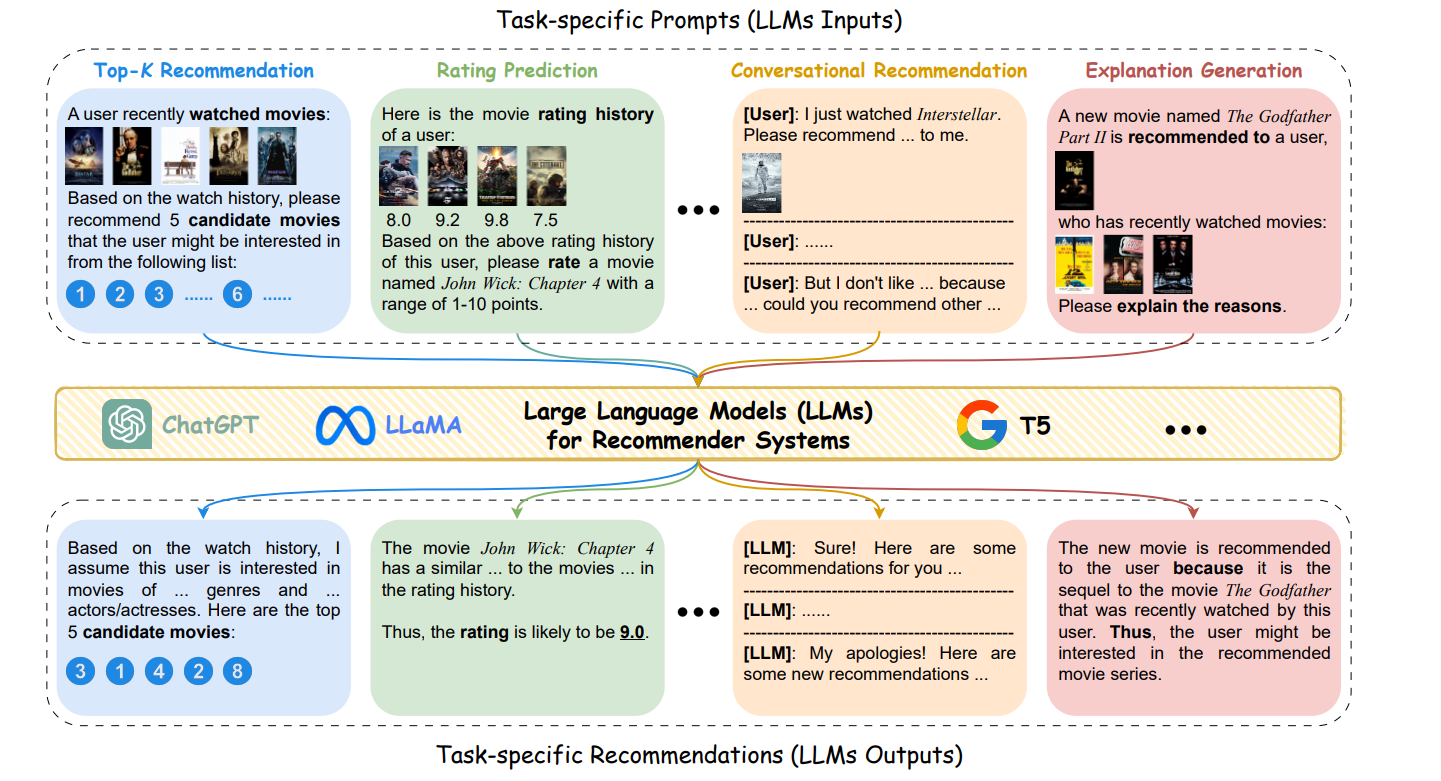

그림 1 :영화 추천 시나리오에서 다양한 추천 작업을 위한 LLM 적용 예시. 이 워크플로에서 LLM은 텍스트 정보(또는 이미지와 같은 멀티모달 데이터)가 추천 작업에 활용되는 작업별 프롬프트를 통해 직접 추천자 역할을 합니다.

앞서 언급한 성공에도 불구하고 대부분의 기존 고급 추천 시스템은 여전히 몇 가지 본질적인 한계에 직면해 있습니다. 첫째, 모델 규모 및 데이터 크기의 제한으로 인해 이전 DNN 기반 모델(예: CNN 및 LSTM)과 추천 시스템용 사전 학습된 언어 모델(예: BERT)은 사용자 및 항목에 대한 텍스트 지식을 충분히 캡처할 수 없어 자연어 이해 능력이 열등하여 다양한 추천 시나리오에서 최적이 아닌 예측 성능을 제공합니다. 둘째, 대부분의 기존 RecSys 방법은 자체 작업을 위해 특별히 설계되었으며 보이지 않는 권장 작업에 대한 일반화 기능이 충분하지 않습니다. 예를 들어, 추천 알고리즘은 영화의 평점 점수를 예측하기 위해 사용자 항목 등급 매트릭스에 대해 잘 훈련되어 있지만 이 알고리즘이 최고 등급을 수행하기는 어렵습니다.𝑘 특정 설명과 함께 영화 추천. 이는 이러한 권장 사항 아키텍처의 설계가 다음과 같은 특정 권장 사항 시나리오에 대한 작업별 데이터 및 도메인 지식에 크게 의존하기 때문입니다.𝑘 추천, 평가 예측 및 설명 가능한 추천. 셋째, 대부분의 기존 DNN 기반 추천 방법은 간단한 결정이 필요한 추천 작업(예: 등급 예측 및 상위 -𝑘 권장 사항). 그러나 여러 추론 단계를 포함하는 복잡하고 다단계 결정을 지원하는 데 어려움을 겪습니다. 예를 들어, 다단계 추론은 여행 계획 추천에 매우 중요한데, RecSys는 먼저 목적지를 기반으로 인기 있는 관광 명소를 고려한 다음 관광 명소에 해당하는 적절한 일정을 마련하고 마지막으로 특정 사용자 선호도(예: 여행 비용 및 시간)에 따라 일지 계획을 추천해야 합니다.

최근에는 고도화된 자연어 처리 기술로서 10억 개의 파라미터를 가진 대규모 언어 모델(LLM)이 자연어 처리(NLP)와 같은 다양한 연구 분야에 큰 영향을 미치고 있습니다 [15], 컴퓨터 비전 [16]및 분자 발견 [17]. 기술적으로 대부분의 기존 LLM은 기사, 책, 웹 사이트 및 기타 공개적으로 사용 가능한 서면 자료와 같은 다양한 소스의 방대한 양의 텍스트 데이터를 사전 훈련한 트랜스포머 기반 모델입니다. LLM의 파라미터 크기가 더 큰 학습 코퍼스와 함께 계속 확장됨에 따라 최근 연구에 따르면 LLM이 놀라운 기능의 출현으로 이어질 수 있습니다 [18, 19]. 좀 더 구체적으로 말하자면, LLM은 언어 이해 및 생성에 대한 근본적인 책임의 전례 없는 강력한 능력을 보여주었습니다. 이러한 개선을 통해 LLM은 인간의 의도를 더 잘 이해하고 본질적으로 더 인간과 유사한 언어 응답을 생성할 수 있습니다. 또한 최근 연구에 따르면 LLM은 인상적인 일반화 및 추론 능력을 보여 LLM이 보이지 않는 다양한 작업 및 도메인으로 더 잘 일반화됩니다. 구체적으로 말하자면, LLM은 각 특정 작업에 대해 광범위한 미세 조정을 요구하는 대신 적절한 지침이나 몇 가지 작업 데모를 제공하는 것만으로도 학습한 지식과 추론 기술을 새로운 작업에 적용할 수 있습니다. 컨텍스트 내 학습과 같은 고급 기술은 특정 다운스트림 작업에 대한 미세 조정 없이 LLM의 일반화 성능을 더욱 향상시킬 수 있습니다 [19]. 또한 생각의 사슬(chain-of-thought)과 같은 프롬프트 전략을 통해 권한을 부여받은 LLM은 복잡한 의사 결정 프로세스에서 단계별 추론을 통해 출력을 생성할 수 있습니다. 따라서 LLM은 강력한 기능을 감안할 때 추천 시스템을 혁신할 수 있는 큰 잠재력을 보여줍니다.

최근에는 차세대 RecSys를 위한 유망한 기술로서 LLM의 잠재력을 탐구하기 위한 초기 노력이 이루어졌습니다. 예를 들어, Chat-Rec [3] 는 ChatGPT를 활용하여 대화를 통해 사용자와 상호 작용한 다음 영화 추천을 위해 기존 RecSys에서 생성된 후보 세트를 개선하여 추천 정확도와 설명 가능성을 높일 것을 제안합니다. Zhang 외. [20] T5를 LLM 기반 RecSys로 사용하여 사용자가 RecSys 입력으로 자연어로 명시적 선호도와 의도를 전달할 수 있도록 하여 단순히 사용자-항목 상호 작용을 기반으로 하는 것보다 더 나은 추천 성능을 보여줍니다. 그림 1은 top-𝐾 추천, 평가 예측, 대화형 추천 및 설명 생성. LLM의 급속한 발전으로 인해 LLM 기반 추천 시스템의 최근 발전과 과제를 종합적으로 검토하는 것이 필수적입니다.

따라서 이 설문조사에서는 LLM의 힘을 활용하기 위한 세 가지 대표적인 접근 방식인 사전 학습, 미세 조정 및 프롬프트 패러다임 측면에서 LLM 기반 추천 시스템에 대한 체계적인 개요를 제공합니다 [21, 19]. 특히 본 조사는 다음과 같이 구성되어 있습니다. 먼저, 섹션 2에서 각각 RecSys 및 LLM 분야의 이정표와 그 조합을 검토합니다. 그런 다음 LLM을 활용하여 사용자 및 항목의 표현을 학습하는 두 가지 기본 유형의 추천 시스템, 즉 ID 기반 RecSys와 텍스트 측면 정보 강화 RecSys에 대해 섹션 3에 설명합니다. 그 후, LLM을 추천 시스템에 적용하기 위한 고급 기법을 섹션 4와 섹션 5에서 각각 사전 학습 및 미세 조정 및 프롬프트 패러다임의 관점에서 종합적으로 요약합니다. 마지막으로, LLM을 권장 사항에 적용함으로써 제기되는 새로운 과제와 몇 가지 잠재적인 미래 방향은 섹션 6에서 논의됩니다.

추천 시스템 영역의 기존 설문 조사를 요약하면 딥 러닝 기술의 관점에서 RecSys의 성능을 촉진하기 위해 다양한 초점이 검토되었습니다 [22, 23, 24, 9], 평가 방법론 [25, 26]신뢰성 [27, 28, 29] 그리고 다른 측면. LLM의 시대에, LLM을 추천 시스템에 통합하는 것은 최근 연구에서 점점 더 주목을 받고 있습니다. 이는 LLM 기반 추천 시스템의 학제 간 분야에서 새로운 트렌드와 고급 기술을 체계적으로 검토하는 것의 중요성과 필요성을 강조합니다. 설문조사 전 또는 동시, Liu et al. [30] 추천 시스템에 대한 언어 모델링 패러다임 적응의 학습 전략과 학습 목표를 검토합니다. 그러나 이 작업은 주로 BERT 및 GPT-2와 같은 RecSys의 초기 단계 언어 모델을 검토합니다. ChatGPT 및 LLaMA와 같은 고급 LLM이 출시된 후 RecSys의 LLM 적응에 놀라운 진화가 이루어졌으며 이는 보다 최신 검토를 촉구합니다. 최근에는 Wu et al. [31] 차별적 관점과 생성적 관점에서 추천 시스템의 LLM을 요약하고, 추천에서 고유한 기능에 맞게 조정된 두 가지 스타일의 LLM을 비교합니다. 한편, Lin et al. [32] 추천 시스템에서 LLM을 어디에 어떻게 적용할 것인가라는 두 가지 직교적 관점을 소개합니다. 특히, 본 설문조사는 RecSys의 파이프라인을 제시하며, 권장 사항을 통해 LLM의 다양한 기능을 검토합니다.

앞서 언급한 진전에도 불구하고, 기존 설문 조사는 주로 LLM 영역에서 제안된 해당 기술이 체계적으로 검토되지 않은 RecSys에서 LLM의 고유한 기능을 다루는 데 있어 LLM의 응용 측면을 강조합니다. 따라서 이번 설문조사는 LLM을 권장 사항에 적용하기 위한 도메인별 기법을 종합적으로 검토하며, 이를 통해 향후 연구를 위해 RecSys에 맞춤화된 LLM 기반 방법을 개발하는 데 도움이 됩니다.

2관련 작품

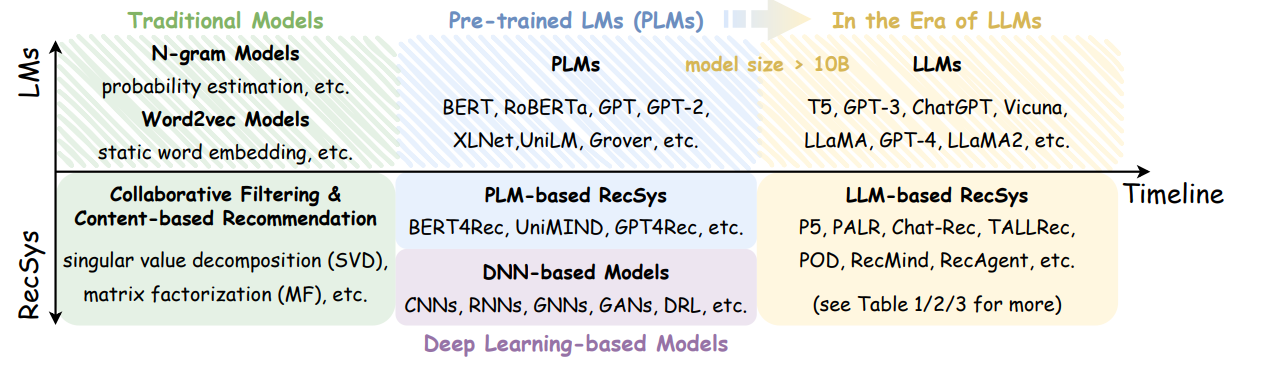

이 섹션에서는 추천 시스템, LLM 및 그 조합에 대한 몇 가지 관련 작업을 간략하게 검토합니다. 그림 2에서 볼 수 있듯이 추천 시스템 및 언어 모델 영역의 이정표에 대한 타임라인이 제공되어 LLM 기반 추천 시스템의 학제 간 분야의 개발을 검토합니다.

그림 2 :추천 시스템(RecSys) 및 LM(언어 모델) 도메인의 마일스톤 타임라인입니다. RecSys 및 LM 도메인을 정렬하기 위해 타임라인은 정확한 기간에 관계없이 기존 모델, 사전 학습된 언어 모델/딥러닝 기반 모델, 색상으로 강조 표시된 LLM 시대의 세 단계에 따라 구성됩니다.

2.1추천 시스템(RecSys)

정보 과부하 문제를 해결하기 위해 추천 시스템은 개별 사용자에게 개인화된 콘텐츠와 서비스를 제공함으로써 다양한 온라인 애플리케이션에서 중요한 도구로 부상했습니다 [33, 34]. 일반적으로 대부분의 기존 권장 사항 접근 방식은 CF(공동 작업 필터링)와 콘텐츠 기반 권장 사항의 두 가지 주요 범주로 나뉩니다. 가장 일반적인 기법인 CF 기반 추천 방법은 사용자의 유사한 행동 패턴을 찾아 향후 상호 작용 가능성을 예측하는 것을 목표로 합니다 [12]이는 구매 내역 또는 평점 데이터와 같은 사용자와 항목 간의 과거 상호 작용 동작을 활용하여 달성할 수 있습니다. 예를 들어, 가장 널리 사용되는 CF 방법 중 하나인 MF(Matrix Factorization)는 순수한 사용자-항목 상호 작용을 사용하여 사용자 및 항목의 표현을 학습하기 위해 도입되었습니다 [35, 7]. 즉, 사용자 및 항목의 고유 ID(즉, 개별 ID)는 추천에 대한 일치 점수를 쉽게 계산할 수 있도록 벡터를 계속 포함하도록 인코딩됩니다 [36, 37]. 콘텐츠 기반 추천 방법은 일반적으로 사용자 인구 통계 또는 항목 설명과 같은 사용자 또는 항목에 대한 추가 지식을 활용하여 추천 성능을 개선하기 위해 사용자 및 항목 표현을 향상시킵니다 [38]. 텍스트 정보는 사용자와 항목이 가장 많이 사용할 수 있는 콘텐츠 중 하나이므로 이 설문조사에서는 주로 텍스트에 중점을 둡니다.

뛰어난 표현 학습 능력으로 인해 딥 러닝 기술은 추천 시스템을 개발하는 데 효과적으로 적용되었습니다 [34, 5]. 예를 들어, NeuMF는 일반 내적을 DNN으로 대체하여 사용자와 항목 간의 비선형 상호 작용을 모델링하는 것이 좋습니다 [39]. RecSys의 데이터가 자연스럽게 그래프 구조화된 데이터로 표현될 수 있다는 점을 고려할 때, GNN 기술은 추천 시스템에 대한 메시지 전파 전략을 통해 노드(즉, 사용자 및 항목)의 의미 있는 표현을 학습하기 위한 주요 딥 러닝 접근 방식으로 취급됩니다 [40, 1, 41, 42]. 사용자 및 항목에 대한 텍스트 지식을 통합하기 위해 DeepCoNN은 CNN을 사용하여 두 개의 병렬 신경망이 있는 항목에 대해 작성된 사용자의 리뷰를 인코딩하여 추천 시스템의 평가 예측에 기여하도록 개발되었습니다 [8]. 한편, 뉴럴 어텐션 프레임워크 NARRE를 도입하여 항목에 대한 사용자의 평가를 동시에 예측하고 예측에 대한 리뷰 수준의 설명을 생성합니다 [43].

최근 언어 모델은 인간의 자연어를 이해하고 생성할 수 있는 능력으로 인해 추천 시스템에서 점점 더 많이 활용되고 있습니다. 이러한 모델은 인간 자연어의 의미와 구문을 이해하도록 설계되었으므로 RecSys는 뉴스 추천과 같은 보다 개인화된 추천을 제공할 수 있습니다 [44, 45]및 약물 권장 사항 [46]. 특히, 사용자 행동의 순차적 특성을 모델링하기 위해 트랜스포머(즉, BERT)의 양방향 인코더 표현을 채택하기 위해 BERT4Rec라는 순차적 추천 방법이 제안됩니다 [47]. 또한 트랜스포머의 언어 생성 기능을 활용하기 위해 Li et al. [48] 트랜스포머 기반 프레임워크를 설계하여 추천 시스템에서 항목 추천과 설명을 동시에 생성할 수 있습니다.

2.2사전 학습된 언어 모델(PLM)에서 대규모 언어 모델(LLM)로

고급 인공 지능(AI) 기술의 일종인 LLM은 자연어의 패턴과 구조를 이해하기 위해 수십억 개의 매개변수가 있는 대량의 텍스처 데이터에 대해 훈련됩니다. BERT(Bidirectional Encoder Representations from Transformers)와 같은 몇 가지 고전적인 유형의 사전 학습된 언어 모델(PLM)을 사용할 수 있습니다 [49], GPT(Generative Pre-trained Transformer, 생성형 사전 훈련된 트랜스포머) [50]및 T5(Text-To-Text Transfer Transformer) [51]. 일반적으로 이러한 언어 모델은 인코더 전용 모델, 디코더 전용 모델 및 인코더-디코더 모델의 세 가지 주요 범주로 나뉩니다.

BERT, GPT 및 T5는 트랜스포머 아키텍처를 기반으로 하는 별개의 모델입니다 [52]. 좀 더 구체적으로 말하자면, 인코더 전용 모델인 BERT는 양방향 어텐션을 사용하여 각 토큰의 왼쪽 및 오른쪽 컨텍스트를 모두 고려하여 토큰 시퀀스를 처리합니다. 마스킹된 언어 모델링 및 다음 문장 예측과 같은 작업을 사용하여 방대한 양의 텍스트 데이터를 기반으로 사전 학습되어 문맥에서 언어와 의미의 뉘앙스를 캡처합니다. 이 프로세스는 텍스트를 벡터 공간으로 변환하여 미묘한 차이와 컨텍스트 인식 분석을 용이하게 합니다. 반면 트랜스포머 디코더 아키텍처를 기반으로 하는 GPT는 왼쪽에서 오른쪽으로 단방향 워드 시퀀스 처리를 위해 셀프 어텐션 메커니즘을 사용합니다. GPT는 주로 언어 생성 작업, 임베딩 벡터를 텍스트 공간에 다시 매핑하고 컨텍스트 관련 응답을 생성하는 데 채택됩니다. 마침내, 인코더-디코더 모델인 T5는 모든 자연어 처리 문제를 텍스트 생성 문제로 변환하여 모든 텍스트-텍스트 작업을 처리할 수 있게 되었습니다. 예를 들어, 감정 분석 작업을 '감정: 이 영화를 사랑합니다.'와 같은 텍스트 시퀀스로 재구성하여 '이 영화를 사랑합니다.' 앞에 '감정:'을 추가할 수 있습니다. 그러면 '긍정'이라는 대답을 얻을 수 있습니다. 이를 통해 T5는 모든 작업에 동일한 모델, 목표 및 훈련 절차를 사용하므로 다양한 NLP 작업을 위한 다목적 도구가 됩니다.

모델의 규모가 증가함에 따라 LLM은 인간과 유사한 텍스트 지식을 이해하고 생성하는 데 있어 전례 없는 기능을 보여줌으로써 NLP 분야에 혁명을 일으켰습니다 [18, 53]. 이러한 모델(예: GPT-3 [15], 람다 [54]손바닥 [55]및 Vicuna [56])은 종종 트랜스포머 아키텍처를 기반으로 하며, 방대한 양의 텍스트 데이터에 대한 학습을 거칩니다. 이 과정을 통해 인간 언어의 복잡한 패턴과 뉘앙스를 포착할 수 있습니다. 최근 LLM은 설계와 기능의 핵심인 개념인 ICL의 놀라운 기능을 보여주었습니다. ICL은 단순히 사전 훈련을 통해 얻은 내부 지식에 의존하는 것이 아니라 입력 컨텍스트를 기반으로 답변을 이해하고 제공하는 모델의 능력을 나타냅니다. SG-ICL과 같은 다양한 작업에서 ICL의 활용을 탐구한 여러 연구가 있습니다 [57] 및 EPR [58]. 이러한 연구는 ICL을 통해 LLM이 일반적인 응답을 생성하는 대신 입력 컨텍스트에 따라 응답을 조정할 수 있음을 보여줍니다. LLM의 추론 능력을 향상시킬 수 있는 또 다른 기술은 CoT(Chain-of-Thought)입니다. 이 방법에는 프롬프트 내에서 생각의 연쇄를 예제로 설명하기 위해 여러 데모를 제공하고 모델의 추론 프로세스를 안내하는 것이 포함됩니다 [59]. CoT의 확장은 답변에 대한 다수결 투표 메커니즘을 구현하여 작동하는 자기 일관성 개념입니다 [60]. 현재 연구는 STaR과 같은 LLM에서 CoT의 적용에 대해 계속 탐구하고 있습니다 [61]토르 [62]및 Tab-CoT [63]. CoT는 모델의 사고 과정을 지시하는 일련의 프롬프트를 제공하여 모델이 보다 효과적으로 추론하고 보다 정확한 응답을 제공할 수 있도록 합니다.

위에서 언급한 강력한 능력을 갖춘 LLM은 화학과 같은 다양한 분야에서 놀라운 잠재력을 보여주었습니다 [17]교육 [64]및 금융 [65]. ChatGPT와 같은 이러한 모델도 RecSys의 기능과 사용자 경험을 향상시키는 데 중요한 역할을 했습니다. RecSys에서 LLM의 주요 응용 프로그램 중 하나는 항목에 대한 사용자 등급을 예측하는 것입니다. 이는 과거 사용자 상호 작용 및 선호도를 분석하여 달성되며, 이를 통해 권장 사항의 정확성이 향상됩니다 [66, 67]. LLM은 또한 TALLRec과 같이 사용자 상호 작용의 시퀀스를 분석하여 다음 선호도를 예측하는 순차적 권장 사항에도 사용되었습니다 [68], M6-녹화 [69], 팔 [70]및 P5 [71]. 또한 LLM, 특히 ChatGPT는 설명 가능한 권장 사항을 생성하는 데 활용되었습니다. 그러한 예 중 하나는 Chat-Rec입니다 [3], ChatGPT를 활용하여 제안에 대한 명확하고 이해하기 쉬운 추론을 제공하여 신뢰와 사용자 참여를 촉진합니다. 또한 LLM의 인터랙티브 및 대화형 기능을 활용하여 보다 역동적인 추천 경험을 제공합니다. 예를 들어, UniCRS [72] 사전 학습된 언어 모델을 기반으로 대화 및 추천 하위 작업을 모두 수행하기 위해 지식이 강화된 프롬프트 학습 프레임워크를 개발합니다. 유니마인드 [73] 대화형 추천 시스템에서 프롬프트 기반 학습 전략을 사용하여 통합된 멀티태스킹 학습 프레임워크를 제안합니다. 또한 그래프 학습에서 LLM의 잠재력을 조사하기 위해 Chen et al. [18] 는 두 가지 가능한 파이프라인, 즉 LLMs-as-Enhancers(예: LLM은 노드 속성의 텍스트 정보를 향상시킴)와 LLM-as-Predictors(예: LLM은 링크 예측 문제와 같은 그래프 학습에서 독립적인 예측자 역할을 함)를 도입하여 그래프 기반 권장 사항을 위한 LLM 설계에 대한 지침을 제공합니다.

3LLM 기반 추천 시스템을 위한 심층 표현 학습

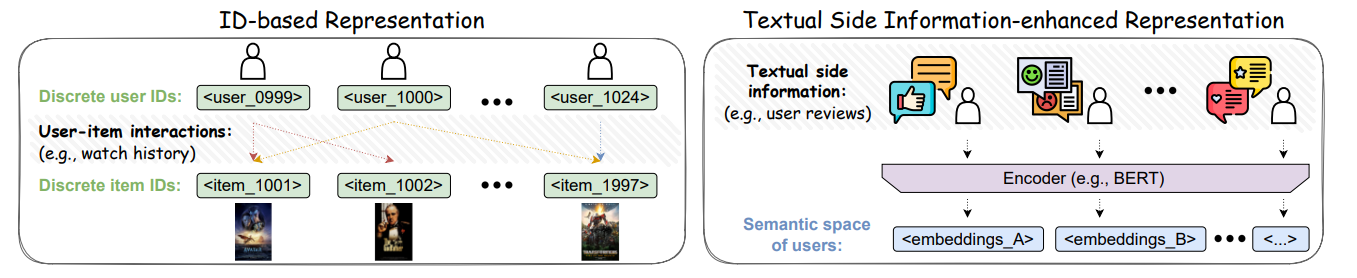

사용자와 항목은 추천 시스템의 원자 단위입니다. 추천 시스템에서 항목과 사용자를 나타내기 위해 간단한 방법은 각 항목 또는 사용자에게 고유한 인덱스(즉, 개별 ID)를 할당합니다. 항목에 대한 사용자의 선호도를 포착하기 위해 ID 기반 추천 시스템은 사용자-항목 상호 작용에서 사용자 및 항목의 표현을 학습하도록 제안됩니다. 또한, 사용자 및 아이템에 대한 텍스트 사이드 정보는 사용자의 관심사를 이해할 수 있는 풍부한 지식을 제공하기 때문에, 추천 시스템에 대한 엔드 투 엔드 트레이닝 방식으로 사용자 및 아이템 표현 학습을 강화하기 위해 텍스트 사이드 정보 강화 추천 방법을 개발한다. 이 섹션에서는 추천 시스템에서 언어 모델을 활용하는 이 두 가지 범주를 소개합니다. 이 두 종류의 추천 시스템은 그림 3에 나와 있습니다.

그림 3 : LLM 기반 추천 시스템에서 사용자와 항목을 표현하는 두 가지 방법, 즉 개별 ID와의 사용자-항목 상호작용을 나타내는 ID 기반 표현과 항목에 대한 사용자 리뷰와 같은 사용자 및 항목의 텍스트 측면 정보를 활용하는 텍스트 사이드 정보 강화 표현에 대한 그림입니다.

3.1ID 기반 추천 시스템

추천 시스템은 일반적으로 다양한 후보 항목에서 결정을 내리기 위한 사용자의 행동에 영향을 주는 데 사용됩니다. 이러한 사용자 행동(예: 클릭, 좋아요, 구독)은 일반적으로 사용자-항목 상호작용으로 표시되며, 여기서 사용자와 항목은 별개의 ID로 표시됩니다. 최신 권장 접근 방식은 각 ID 표현의 임베딩 벡터를 학습하여 이러한 동작을 모델링하기 위해 제안됩니다. 일반적으로, LLM 기반 추천 시스템에서, 아이템 또는 사용자는 다음과 같은 형식의 짧은 문구로 표현될 수 있다. ``[𝑝𝑟𝑒𝑓나는𝑥]_[나는𝐷]"여기서 접두사는 유형(예: 항목 또는 사용자)을 나타내고 ID 번호는 고유성을 식별하는 데 도움이 됩니다.

LLM 기반 방법의 초기 탐색으로 다양한 추천 데이터 형식의 전송을 용이하게 하기 위해 P5라는 통합 패러다임이 제안되었습니다 [71], 사용자-항목 상호 작용, 사용자 프로필, 항목 설명 및 사용자 리뷰와 같은 사용자와 항목을 인덱스에 매핑하여 자연어 시퀀스로 변환합니다. 사전 학습된 T5 백본은 개인화된 프롬프트로 P5를 학습하는 데 사용됩니다. 한편, P5는 LLM의 어휘에서 이러한 인덱스를 특수 토큰으로 취급하기 위해 한 쌍의 꺾쇠 괄호와 함께 일반 인덱스 문구를 통합합니다(예: <나는𝑡𝑒𝑚_6637>), 문구를 별도의 토큰으로 토큰화하는 것을 방지합니다.

P5를 기반으로 Hua et al.은 간단하지만 효과적인 네 가지 인덱싱 솔루션을 제시했습니다 [74]: 순차적 인덱싱, 협업 인덱싱, 시맨틱(콘텐츠 기반) 인덱싱, 하이브리드 인덱싱 등 인덱싱 방법의 중요성을 강조합니다. P5가 각 사용자 또는 항목에 숫자 ID를 무작위로 할당하는 것과는 달리, 각 사용자 또는 항목에 대한 의미론적 의미를 가진 코드워드의 튜플인 시맨틱 ID는 각각 특정 사용자 또는 항목에 대한 의미론적 의미를 전달하는 고유 식별자 역할을 하도록 제안됩니다 [75]. 한편, 이러한 코드워드를 생성하기 위해 RQ-VAE라는 계층적 방법도 제안된다 [75] 추천 데이터 형식을 트랜스포머 기반 모델의 자연어 시퀀스로 효과적으로 변환할 수 있는 시맨틱 ID를 활용합니다.

3.2텍스트 사이드 정보(Textual Side Information)로 강화된 추천 시스템

앞서 언급한 성공에도 불구하고 ID 기반 방법은 본질적인 한계에 직면해 있습니다. 이는 사용자 및 항목의 순수 ID 인덱싱이 자연적으로 별개이기 때문에 권장 사항에 대한 사용자 및 항목의 표현을 캡처하기에 충분한 의미 정보를 제공할 수 없기 때문입니다. 따라서 사용자와 항목 간의 인덱스 표현을 기반으로 관련성 계산을 수행하는 것은 매우 어려우며, 특히 사용자-항목 상호 작용이 심각하게 드문 경우 더욱 그렇습니다. 한편, ID 인덱싱은 일반적으로 어휘를 수정하고 LLM의 매개변수를 변경해야 하므로 추가 계산 비용이 발생합니다.

이러한 한계를 해결하기 위해 유망한 대안 솔루션은 사용자 및 항목의 텍스트 사이드 정보를 활용하는 것입니다. 여기에는 사용자 프로필, 항목에 대한 사용자 리뷰, 항목 제목 또는 설명이 포함됩니다. 특히, 항목 또는 사용자의 텍스트 측면 정보가 주어지면 BERT와 같은 언어 모델은 항목 또는 사용자를 의미 공간에 매핑하는 텍스트 인코더 역할을 할 수 있으며, 여기에서 유사한 항목 또는 사용자를 그룹화하고 보다 세분화된 세분성으로 차이점을 파악할 수 있습니다. 예를 들어, Li et al.은 ID와 모달리티 기반 추천 시스템 간의 성능 비교를 조사하여 ID 기반 추천 시스템이 사이드 정보를 더 잘 활용할 수 있는 추천 시스템에 의해 도전을 받을 수 있음을 보여주었습니다 [76]. 한편, Unisec [77] 는 항목 설명을 활용하여 다양한 권장 사항 시나리오에서 전송 가능한 표현을 학습하는 방법 중 하나입니다. 보다 구체적으로, Unisec은 파라메트릭 화이트닝 및 MoE(Mixture-of-Experts) 향상된 어댑터를 사용하여 범용 항목 표현을 인코딩하는 경량 항목 인코더도 도입했습니다. 또한 텍스트 기반 협업 필터링(TCF)은 GPT-3와 같은 LLM을 프롬프트하여 탐색합니다 [78]. 이전의 ID 기반 협업 필터링과 비교했을 때, TCF 방법은 긍정적인 성능을 보여주며 텍스트 사이드 정보 강화 추천 시스템의 잠재력을 입증했습니다.

그러나 언어 모델에만 의존하여 항목 설명을 인코딩하면 텍스트 기능이 과도하게 강조될 수 있습니다. 이 문제를 완화하기 위해 VQ-Rec [79] 항목 텍스트를 개별 인덱스(즉, 항목 코드)의 벡터로 매핑하고 이를 사용하여 권장 사항의 코드 임베딩 테이블에서 항목 표현을 검색할 수 있는 벡터 양자화된 항목 표현을 학습할 것을 제안합니다. 텍스트 기능을 넘어서, Fan et al. [80] ZSIR(Zero-Shot Item-based Recommendation)을 위한 새로운 방법을 제안하며, LLM에 PKG(Product Knowledge Graph)를 도입하여 아이템 기능을 개선하는 데 중점을 둡니다. 좀 더 구체적으로 말하자면, 사용자 및 항목 임베딩은 PKG에서 여러 사전 학습 작업을 통해 학습됩니다. 또한, ShopperBERT [81] 사용자 구매 내역을 기반으로 여러 사전 학습 작업을 통해 사용자 임베딩을 사전 학습하는 전자 상거래 추천 시스템에서 사용자 표현을 나타내기 위한 사용자 행동 모델링을 조사합니다. 또한, IDA-SR [81]순차 추천을 위한 ID에 구애받지 않는 사용자 행동 사전 학습 프레임워크는 BERT와 같은 사전 학습된 언어 모델을 사용하여 텍스트 정보의 표현을 직접 유지합니다. 구체적으로 말하자면, 항목이 주어지면 나는 그리고 그 설명은 다음과 같습니다. 𝑚 토큰 𝐷나는={𝑡1,𝑡2,...,𝑡𝑚}, 추가 시퀀스 시작 토큰 [𝐶𝐿𝑆] 가 설명에 추가됩니다. 𝐷나는={[𝐶𝐿𝑆],𝑡1,𝑡2,...,𝑡𝑚}. 그런 다음 설명이 LLM에 대한 입력으로 제공됩니다. 마지막으로 토큰의 임베딩 [𝐶𝐿𝑆] ID에 구애받지 않는 항목 표현으로 사용할 수 있습니다.

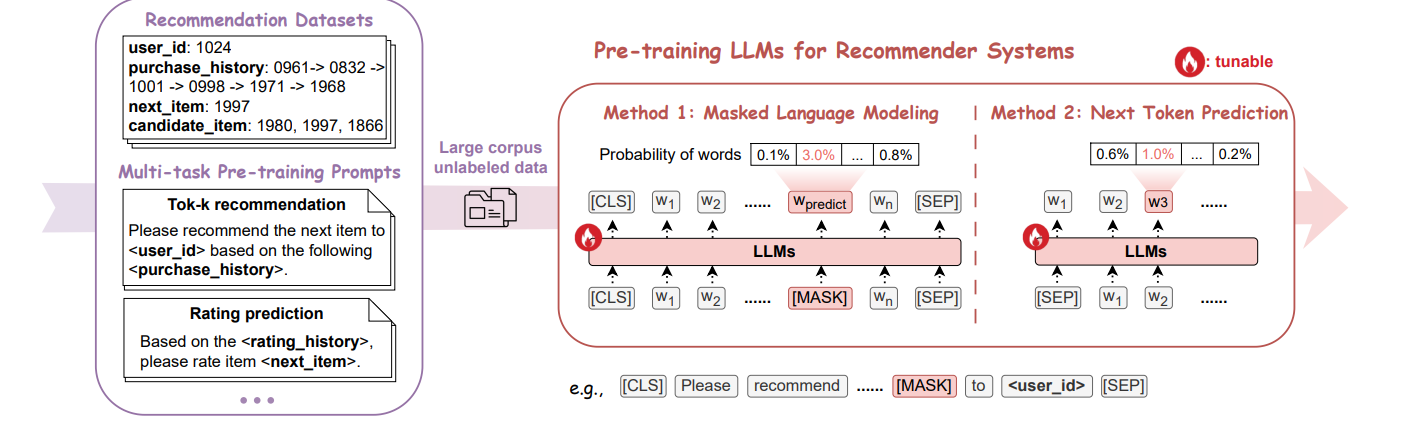

그림 4 :두 가지 대표적인 방법, 즉 시퀀스에서 토큰 또는 스팬을 무작위로 마스킹하고 LLM이 나머지 컨텍스트를 기반으로 마스킹된 토큰 또는 스팬을 생성하도록 요구하는 마스킹 언어 모델링(Masked Language Modeling)과 주어진 컨텍스트를 기반으로 다음 토큰에 대한 예측이 필요한 다음 토큰 예측(Next Token Prediction)의 관점에서 추천 시스템을 위한 사전 학습 LLM의 워크플로입니다.

표 I:LLM 기반 RecSys를 위한 사전 학습 방법.

| 패러다임 | 방법 | 사전 학습 작업 | 코드 가용성 |

| 사전 교육 | PTUM [82] | 마스킹된 동작 예측 | \urlhttps://github.com/wuch15/PTUM |

| Next K 행동 예측 | |||

| M6 시리즈 [69] | 자동 회귀 생성 | 사용할 수 없음 | |

| P5 시리즈 [71] | 멀티태스킹 모델링 | \urlhttps://github.com/jeykigung/P5 |

4추천 시스템을 위한 사전 학습 및 미세 조정 LLM

일반적으로 추천 작업에서 LLM을 개발하고 배포하는 데에는 사전 학습, 미세 조정, 프롬프트라는 세 가지 주요 방법이 있습니다. 이 섹션에서는 먼저 그림 4와 그림 5에 각각 나와 있는 사전 학습 및 미세 조정 패러다임을 소개합니다. 좀 더 구체적으로 말하자면, 추천 시스템을 위해 LLM에 적용되는 특정 사전 학습 작업과 다운스트림 추천 작업의 성능 향상을 위한 미세 조정 전략에 중점을 둘 것입니다. 아래에 언급된 저작물은 표 I과 표 II에 요약되어 있습니다.

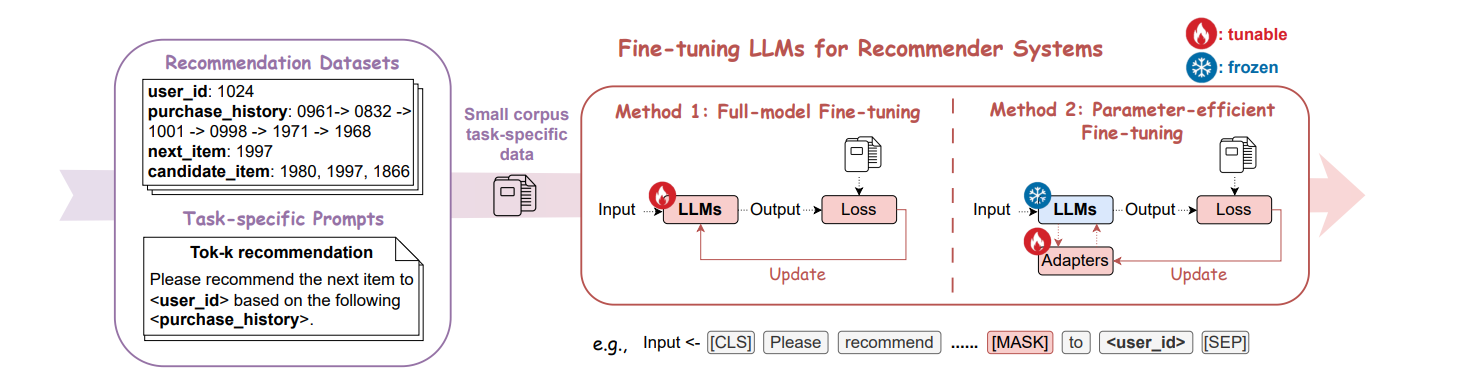

그림 5 :두 가지 대표적인 방법, 즉 전체 모델 가중치를 변경하는 전체 모델 미세 조정(Full-model Fine-tuning)과 대부분의 매개 변수를 수정하면서 모델 가중치의 작은 비율 또는 몇 가지 추가 학습 가능한 가중치를 미세 조정하는 파라미터 효율적 미세 조정(Parameter-efficient Fine-tuning)의 관점에서 추천 시스템을 위한 LLM을 미세 조정하는 워크플로입니다.

표 II:LLM 기반 RecSys를 위한 미세 조정 방법.

| 패러다임 | 방법 | 참조 |

| 미세 조정 | 전체 모델 미세 조정 | [83], [84], [85], [86], [87], [88]그리고 [89]1 |

| 파라미터 효율적인 미세 조정 | [68]2, [90]그리고 [69] | |

| 코드 가용성: 1\urlhttps://github.com/veason-silverbullet/unitrec, 2\urlhttps://github.com/sai990323/tallrec | ||

4.1추천 시스템을 위한 사전 학습 패러다임

사전 학습은 전이 학습의 개념을 계승하는 LLM 개발의 중요한 단계입니다. 여기에는 다양하고 레이블이 지정되지 않은 텍스트 데이터로 구성된 방대한 양의 말뭉치에 대한 LLM 훈련이 포함됩니다. 이 전략을 통해 LLM은 문법, 구문, 의미론, 심지어 상식적 추론을 포함한 다양한 언어적 측면에 대한 광범위한 이해를 얻을 수 있습니다. 사전 학습을 통해 LLM은 일관되고 상황에 맞는 응답을 인식하고 생성하는 방법을 학습할 수 있습니다. 일반적으로 자연어 처리의 관점에서 LLM을 사전 학습시키는 두 가지 주요 패러다임이 있는 반면, 사전 학습 전략의 선택은 특정 모델 구조에 따라 다릅니다. 인코더 전용 또는 인코더-디코더 트랜스포머 구조의 경우 MLM(Masked Language Modeling)이 널리 채택되어 시퀀스의 토큰 또는 스팬을 무작위로 마스킹하고 LLM이 나머지 컨텍스트를 기반으로 마스킹된 토큰 또는 스팬을 생성해야 합니다 [91]. 동시에 NTP(Next Token Prediction)는 사전 학습 디코더 전용 트랜스포머 구조를 위해 배포되며, 지정된 컨텍스트를 기반으로 다음 토큰에 대한 예측이 필요합니다 [50]. 두 가지 사전 학습 과제 모두 조건문 완성을 포함하지만 접근 방식에는 차이가 있습니다. MLM(Masked Language Model) 작업은 양방향 컨텍스트에서 마스킹된 토큰을 예측하는 반면, NTP(Next Sentence Prediction) 작업은 이전 컨텍스트만 고려합니다. 결과적으로 MLM은 LLM이 토큰의 의미를 더 잘 이해하는 데 도움이 될 수 있는 반면 NTP는 언어 생성 작업에 더 자연스럽습니다.

추천 시스템에서 기존 작업의 대부분은 두 가지 고전적인 사전 학습 패러다임을 따릅니다. 다음으로 몇 가지 대표적인 방법을 소개합니다. PTUM [82] 에서는 추천 시스템에서 사용자 행동을 모델링하기 위해 MBP(Masked Behavior Prediction) 및 NBP(Next K behavior Prediction)라는 두 가지 유사한 사전 학습 작업을 제안합니다. 언어 토큰과 달리 사용자 행동은 더 다양하므로 예측하기가 더 어렵습니다. 이 경우 PTUM은 토큰 범위를 마스킹하는 대신 대상 사용자의 상호 작용 시퀀스에 있는 다른 동작을 기반으로 마스킹된 동작을 예측하기 위해 단일 사용자 동작만 마스킹합니다. 반면에 NBP는 사용자 모델링에 중요한 과거와 미래 행동 간의 관련성을 모델링합니다. NBP의 목표는 다음을 예측하는 것입니다. 𝑘 사용자-항목 상호 작용 기록을 기반으로 하는 동작입니다. 사용자 행동의 시간 시퀀스를 고려할 때 NBP는 자연스럽게 사용자를 시뮬레이션하여 더 나은 성능을 보여줄 수 있습니다.

M6 시리즈 [69] 또한 두 가지 고전적인 사전 학습 작업, 즉 텍스트 채우기 목표와 자동 회귀 언어 생성 목표에 의해 동기 부여된 두 가지 사전 학습 목표를 각각 위의 두 가지 사전 학습 작업에 해당합니다. 좀 더 구체적으로 말하자면, 텍스트 채우기 목표는 BART의 사전 학습 작업을 나타냅니다 [92]는 텍스트 시퀀스에서 여러 토큰이 있는 범위를 무작위로 마스킹하고 이러한 마스킹된 범위를 사전 학습 대상으로 예측하여 권장 사항 점수 매기기 작업에서 텍스트 또는 이벤트의 타당성을 평가하는 기능을 제공합니다. 한편, 자동 회귀 언어 생성 목표는 자연어 사전 학습에서 Next Token Prediction 작업을 따르지만, 마스킹된 시퀀스를 기반으로 마스킹되지 않은 문장을 예측한다는 점에서 약간 다릅니다.

또한 P5는 다중 마스크 모델링을 채택하고 사전 학습을 위해 다양한 추천 작업의 데이터 세트를 혼합합니다. 이 경우 다양한 추천 업무는 물론 제로샷 생성 능력으로 보이지 않는 업무까지 일반화할 수 있다 [71]. 다양한 권장 사항 작업에서 P5는 섹션 3에 설명된 대로 언어 시퀀스로 사용자 및 항목을 나타내기 위한 통합 인덱싱 방법을 적용하여 마스킹 언어 모델링 작업을 사용할 수 있도록 합니다.

4.2추천 시스템을 위한 패러다임 미세 조정

미세 조정은 특정 다운스트림 작업을 위해 사전 훈련된 LLM을 배포하는 데 중요한 단계입니다. 특히 추천 작업의 경우 LLM은 더 많은 도메인 지식을 파악하기 위해 미세 조정이 필요합니다. 특히, 패러다임의 미세 조정에는 사용자-항목 상호 작용 행동(예: 구매, 클릭, 평점)과 사용자 및 항목에 대한 부수적인 지식(예: 사용자의 사회적 관계 및 항목 설명)을 포함하는 작업별 추천 데이터 세트를 기반으로 사전 학습된 모델을 학습하는 것이 포함됩니다. 이 프로세스를 통해 모델은 권장 사항 도메인의 성능을 개선하기 위해 지식과 매개 변수를 전문화할 수 있습니다. 일반적으로 미세 조정 전략은 주어진 작업에 맞게 변경된 모델 가중치의 비율에 따라 두 가지 범주로 나눌 수 있습니다. 하나는 전체 모델 미세 조정으로, 미세 조정 프로세스에서 전체 모델 가중치를 변경합니다. 계산 비용을 고려하는 다른 하나는 매개 변수 효율적인 미세 조정으로, 가중치의 작은 부분만 변경하거나 특정 작업에 맞게 학습 가능한 어댑터를 개발하는 것을 목표로 합니다.

4.2.1전체 모델 미세 조정

특정 다운스트림 권장 사항 작업에 맞게 사전 훈련된 LLM을 배포하는 간단한 전략으로, 전체 모델 미세 조정에는 전체 모델 가중치 변경이 포함됩니다. 예: RecLLM [83] 는 LaMDA를 YouTube 동영상 추천을 위한 CRS(Conversational Recommender System)로 미세 조정할 것을 제안합니다. 한편, GIRL [87] LLM에게 작업 추천을 지시하기 위해 감독 미세 조정 전략을 활용합니다. 그러나 LLM을 직접 미세 조정하면 추천 시스템에 의도하지 않은 편향이 발생하여 성별, 인종 및 직업과 같은 민감한 속성을 기반으로 특정 그룹이나 개인에게 심각한 피해를 줄 수 있습니다. 이러한 유해한 영향을 완화하기 위해 간단한 LLM 기반 권장 사항(LMRec) [84] 비우선 엔티티의 학습 측 마스킹 및 테스트 측 중화를 통해 관찰된 편향을 완화하기 위해 개발되었으며, 이는 심각한 성능 저하 없이 만족스러운 결과를 달성합니다. 트랜스렉 [85] 사전 훈련된 추천 시스템을 종단 간 방식으로 연구하며, 혼합된 양식 항목(예: 텍스트 및 이미지)의 원시 기능에서 직접 학습합니다. 이 경우 중복된 사용자 또는 항목에 의존하지 않고 TransRec을 다른 시나리오로 효과적으로 전송할 수 있습니다. 또한, Carranza et al. [86] DP 교육의 특정 문제와 한계를 완화하는 DP(Differentially Private) LLM을 적용하여 개인 정보를 보호하는 대규모 추천 시스템을 제안합니다.

대조적 학습은 추천 시스템에서 LLM을 미세 조정하기 위한 인기 있는 접근 방식으로도 부상했습니다. 이 방향으로 몇 가지 방법이 제안되었습니다. 스베르트 [88] 의도 문장이 앵커와 짝을 이루는 삼중 손실 함수를 도입하고, 해당 제품은 전자 상거래 영역에서 긍정적 및 부정적 예로 사용됩니다. 또한 UniTRec [89] 텍스트 기반 추천을 개선하기 위해 차별적 일치 점수와 후보 텍스트 복잡성을 대조 목표로 결합하는 통합 프레임워크를 제안합니다.

4.2.2파라미터 효율적인 미세 조정

전체 모델 미세 조정에는 LLM의 크기가 확장됨에 따라 대규모 컴퓨팅 리소스가 필요합니다. 현재로서는 단일 소비 수준 GPU가 일반적으로 100억 개 이상의 파라미터를 가진 가장 진보된 LLM을 미세 조정하는 것은 불가능합니다. 이 경우 PEFT(Parameter-efficient Fine-tuning)는 컴퓨팅 리소스에 대한 요구 사항이 더 낮은 LLM을 효율적으로 미세 조정하는 것을 목표로 합니다. PEFT는 전체 모델 미세 조정과 비슷한 성능을 달성하기 위해 LLM에서 대부분의 매개 변수를 수정하면서 모델 가중치의 작은 부분 또는 몇 가지 추가 학습 가능한 가중치를 미세 조정하는 것을 포함합니다.

현재 가장 인기 있는 PEFT 방법은 추가 훈련 가능한 가중치를 어댑터로 도입하는 것입니다. 어댑터 구조는 LLM의 트랜스포머 구조에 임베딩하기 위해 설계되었습니다 [93]. 각 트랜스포머 레이어에 대해 어댑터 모듈이 두 번 추가됩니다: 첫 번째 모듈은 멀티 헤드 어텐션 후 투영 후에 추가되고, 다른 모듈은 두 개의 피드포워드 레이어 뒤에 추가됩니다. 미세 조정 중에 사전 훈련된 LLM의 원래 가중치는 고정되는 반면, 어댑터와 레이어 정규화 레이어는 다운스트림 작업에 맞게 미세 조정됩니다. 따라서 어댑터는 LLM의 확장 및 일반화에 기여하여 전체 모델 미세 조정 및 치명적인 망각 문제를 완화합니다. LLM의 가중치 행렬의 어댑터와 낮은 내재 순위에 대한 아이디어에서 영감을 받은 LoRA(Low-Rank Adaptation of LLMs) [94] 파라미터의 변화를 시뮬레이션하기 위해 낮은 순위의 분해를 도입합니다. 기본적으로 LoRA는 LLM의 원래 구조에서 행렬 곱셈을 처리하는 특정 모듈에 대한 새로운 경로를 추가합니다. 경로에서 두 개의 직렬 행렬은 먼저 차원을 중간 계층의 미리 정의된 차원으로 줄인 다음 차원을 다시 늘립니다. 이 경우 중간 레이어의 차원은 고유 순위를 시뮬레이션할 수 있습니다.

추천 시스템에서 PEFT는 추천 작업을 위해 LLM을 미세 조정하는 계산 비용을 크게 줄일 수 있으므로 업데이트가 덜 필요하고 대부분의 모델 기능을 유지할 수 있습니다. 톨렉 [68] 단일 RTX 3090에서 실행할 수 있는 권장 작업에 맞게 LLaMA-7B 모델 및 LoRA에 대한 효율적이고 효과적인 튜닝 프레임워크를 소개합니다. (주)지엘렉 [90] LoRA를 활용하여 LLM을 작업 추천자로 미세 조정하고 조정합니다. LLaRA (라라) [95] 또한 LoRA를 활용하여 LLM을 미세 조정하여 LLM이 다양한 작업에 적합하도록 합니다. 또한, M6 [69] LoRA 미세 조정을 적용하여 전화 장치에 LLM을 배포할 수 있습니다.

5추천 시스템에 대한 LLM 프롬프트

그림 6 : 세 가지 대표적인 방법으로 추천 시스템에 대해 LLM을 프롬프트하는 워크플로: LLM의 파라미터 업데이트가 필요 없는 In-context Learning(위), LLM에 새로운 프롬프트 토큰을 추가하고 LLM의 입력 레이어에서 최소한의 파라미터 업데이트와 함께 프롬프트를 최적화하는 Prompt Tuning(가운데), 여러 작업별 프롬프트에 대해 LLM을 미세 조정하는 Instruction Tuning(아래) 지침이라고도 합니다.

표 III:LLM 기반 RecSys에 대한 프롬프트, 프롬프트 튜닝 및 명령 튜닝 메서드. 특히 LLM과 RecSys의 통합은 세 가지 대표적인 접근 방식으로 분류됩니다. ⟨ LLM은 추천자 역할을 합니다. ⟩ (예를 들어, LLM은 Tok-K 추천 및 설명 생성과 같은 추천 작업을 직접 수행합니다. ⟨ 브릿지 LLM 및 RecSys ⟩ (예를 들어, LLM은 추천 모델 훈련을 위한 데이터 증강을 제공합니다. ⟨ LLM 기반 자율 에이전트 ⟩ (예를 들어, LLM은 RecSys & Manage 복잡한 권장 사항을 하위 작업으로 시뮬레이션하여 인간 수준의 사용자 행동을 시뮬레이션합니다.

| 참조 | ||||

| 메시지 | 기존 프롬프트 | 텍스트 요약 | 챗GPT | |

| 관계 추출 | 챗GPT | |||

| GPT-4 (영어) | ||||

| 상황 내 학습(ICL) | 챗GPT | |||

| T5 시리즈 | ||||

| 추천 작업(예: 등급 예측, Top-K 추천,대화 추천, 설명 생성 등) | 손바닥 | |||

| GPT-4 (영어) | ||||

| 챗GPT | ||||

| RecSys의 데이터 증강 | GPT-3 영어 | |||

| 챗GPT | ||||

| GPT-3 영어 | ||||

| GPT-2 (영어) | ||||

| RecSys의 데이터 세분화 | 챗GLM | |||

| RecSys 및 도구의 API 호출 | 챗GPT | |||

| GPT-4 (영어) | ||||

| 사용자 행동 시뮬레이션 | 챗GPT | |||

| 작업 계획 | 라마 | |||

| 생각의 사슬(CoT) | 추천 작업 | T5 시리즈 | ||

| GPT-4 (영어) | ||||

| 작업 계획 | 챗GPT | |||

| 프롬프트 튜닝 | 하드 프롬프트 튜닝 | 추천 작업 | GPT-2 (영어) | |

| ICL은 프롬프트 튜닝, 즉 하드 프롬프트 튜닝의 하위 클래스로 간주될 수 있습니다(설명은 섹션 5.2.1 참조) | ||||

| 소프트 프롬프트 튜닝 | T5 시리즈 | |||

| GPT-2 (영어) | ||||

| 손바닥 | ||||

| 추천 작업 | M6 시리즈 | |||

| 명령어 튜닝 | 전체 모델 튜닝프롬프트 포함 | T5 시리즈 | ||

| 추천 작업 | 라마 | |||

| 추천 작업 | 라마 | |||

| 코드 가용성: 1\urlhttps://github.com/AaronHeee/LLMs-as-Zero-Shot-Conversational-RecSys, 2\urlhttps://github.com/rainym00d/LLM4RS, | ||||

| 3\urlhttps://github.com/RUCAIBox/LLMRank, 4\urlhttps://github.com/RUCAIBox/iEvaLM-CRS, 5\urlhttps://github.com/JacksonWuxs/PromptRec, | ||||

| 6\urlhttps://github.com/Jyonn/GENRE-requests, 7\urlhttps://github.com/HKUDS/LLMRec, | ||||

| 8\urlhttps://github.com/YunjiaXi/Open-WorldKnowledge-Augmented-Recommendation, 9\urlhttps://github.com/jwzhanggy/Graph_Toolformer, | ||||

| 10\urlhttps://github.com/RUC-GSAI/YuLan-Rec, 11\urlhttps://github.com/LehengTHU/Agent4Rec, | ||||

| 12\urlhttps://anonymous.4open.science/r/LLM4Rec-Recsys, 13\urlhttps://github.com/rutgerswiselab/GenRec 입니다. | ||||

사전 학습 및 패러다임 미세 조정 외에도 프롬프트는 작업별 프롬프트를 통해 LLM을 특정 다운스트림 작업에 적용하기 위한 최신 패러다임 역할을 합니다. 프롬프트는 LLM 입력에 적용할 수 있는 텍스트 템플릿을 나타냅니다. 예를 들어, "The relation between _ and _ is _." 프롬프트는 관계 추출 작업을 위해 LLM을 배포하도록 설계할 수 있습니다. 프롬프트를 통해 LLM은 다양한 다운스트림 작업을 언어 생성 작업으로 통합할 수 있으며, 이는 사전 학습 중에 목표에 맞게 조정됩니다 [122]. 대규모 태스크별 데이터 세트와 비용이 많이 드는 파라미터 업데이트가 필요한 사전 학습 및 미세 조정 LLM과 비교했을 때, 프롬프트를 사용하면 자연어로 적절한 태스크 지침을 제공하는 등 보다 가벼운 방식으로 LLM을 추천 태스크에 적용할 수 있습니다. 예를 들어, 인기 있는 ChatGPT 검색 플러그인1 ChatGPT의 입력에 대한 프롬프트로 사용자 지정된 문서를 검색하는 프롬프트의 API 스키마 역할을 합니다. 표 III에서 강조한 바와 같이, LLM에 권장 사항을 요청하는 인사이트를 세 가지 대표적인 접근 방식, 즉 추천 역할을 하는 LLM, Bridge LLM 및 RecSys, LLM 기반 자율 에이전트, 프롬프트 메서드의 각 하위 클래스로 분류합니다.

최근 연구에서는 추천을 위한 LLM의 성능을 촉진하기 위한 프롬프트를 적극적으로 탐구했으며, 다양한 추천 작업을 위한 프롬프트를 수동으로 설계하기 위해 ICL(In-context Learning) 및 CoT(Chain-of-Thought)와 같은 고급 기술이 점점 더 많이 연구되고 있습니다. 또한 프롬프트 튜닝은 LLM에 프롬프트 토큰을 추가한 다음 작업별 추천 데이터 세트를 기반으로 업데이트하여 프롬프트를 추가하는 추가 기술 역할을 합니다. 최근에는 사전 학습 미세 조정 패러다임과 프롬프트를 결합한 명령 튜닝 &[123] 는 명령 기반 프롬프트를 사용하여 여러 추천 작업에 걸쳐 LLM을 미세 조정하는 방법을 탐구하며, 이를 통해 보이지 않는 권장 작업에 대한 LLM의 제로샷 성능을 향상시킵니다. 그림 6은 앞서 언급한 LLM의 세 가지 프롬프트 기법 각각에 해당하는 대표적인 방법을 추천 시스템에서 LLM의 워크플로우, 입력 형성 및 LLM의 파라미터 업데이트(즉, 조정 가능 또는 고정)와 비교한 것입니다. 이 섹션에서는 추천 작업에서 LLM의 성능을 개선하기 위한 프롬프트, 프롬프트 튜닝 및 명령어 튜닝 기술에 대해 자세히 설명합니다. 요약하면, 표 III은 앞서 언급한 세 가지 기법에 따라 기존 저작물을 분류한 것으로, 구체적인 추천 과제와 이 저작에서 고려되는 LLM 백본을 포함한다.

5.1메시지

프롬프트의 핵심 아이디어는 LLM을 고정(즉, 파라미터 업데이트 없음)하고 작업별 프롬프트를 통해 LLM을 다운스트림 작업에 맞게 조정하는 것입니다. LLM을 다운스트림 작업에 적용하기 위한 프롬프트 전략의 개발을 요약하자면, 초기 단계의 기존 프롬프트 방법은 주로 텍스트 요약, 관계 추출 및 감정 분석과 같은 언어 생성 방식으로 다운스트림 작업을 통합하는 것을 목표로 합니다. 나중에, ICL [15] 는 LLM이 컨텍스트 정보를 기반으로 새로운 작업(즉, 지식을 요구하는 목표가 있는 작업)을 학습할 수 있도록 하는 강력한 프롬프트 전략으로 등장합니다. 또한 CoT라는 또 다른 최신 프롬프트 전략이 있습니다 [59] LLM이 복잡한 추론으로 다운스트림 작업을 처리하도록 유도하는 데 특히 효과적인 방법입니다.

5.1.1기존 프롬프트

특정 다운스트림 작업의 성능을 개선하기 위해 미리 학습된 언어 모델을 프롬프트하는 두 가지 주요 접근 방식이 있습니다. 한 가지 접근 방식은 프롬프트 엔지니어링으로, 언어 모델이 사전 학습 중에 접한 텍스트(예: NLP 작업의 텍스트)를 에뮬레이트하여 프롬프트를 생성합니다. 이를 통해 사전 학습된 언어 모델은 보이지 않는 목표가 있는 다운스트림 작업을 알려진 목표가 있는 언어 생성 작업으로 통합할 수 있습니다. 예를 들어, Liu et al. [48] ChatGPT가 "요약할 짧은 문장 쓰기" 프롬프트를 사용하여 권장 사항의 검토 요약 작업을 텍스트 요약의 일반 언어 생성 작업으로 형식화하도록 프롬프트를 표시하는 것을 고려하십시오. 또 다른 접근 방식은 몇 가지 입력-출력 예제(즉, 샷)를 제공하여 특정 다운스트림 작업에 대해 원하는 출력을 생성하도록 사전 학습된 언어 모델을 프롬프트하고 안내하는 몇 가지 입력-출력 프롬프트입니다.

언어 생성 작업(즉, LLM의 사전 학습 목표)과 다운스트림 추천 작업 사이의 큰 차이로 인해 대부분의 기존 프롬프트 방법은 사용자 검토 요약과 같이 언어 생성 작업과 유사한 특성을 가진 특정 권장 작업에서만 제한된 응용 프로그램을 보여주었습니다 [48] 그리고 항목 간의 관계 레이블 지정 [4].

5.1.2상황 내 학습(ICL)

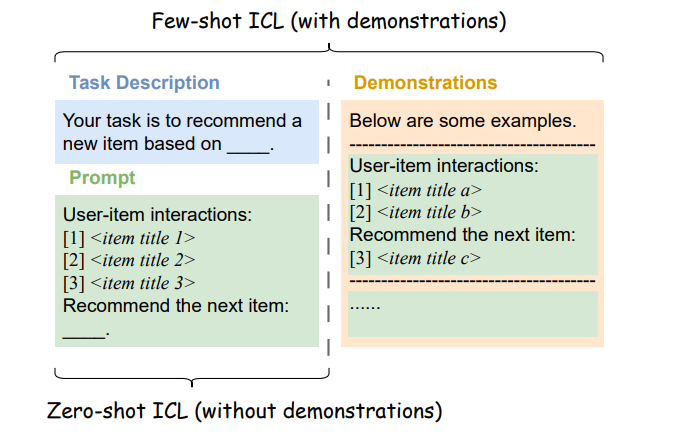

GPT-3 도입과 함께 [15], ICL은 많은 다운스트림 작업에 적응할 때 LLM의 성능을 크게 향상시키는 고급 프롬프트 전략으로 제안됩니다. Gao 외 [122] 다운스트림 작업을 위해 LLM을 프롬프트하는 ICL의 성공은 프롬프트 및 컨텍스트 내 데모라는 두 가지 설계에 기인합니다. 다시 말해, ICL의 핵심 혁신은 추론 단계에서 컨텍스트에서 (새롭거나 보이지 않는) 다운스트림 작업을 학습하기 위해 LLM의 컨텍스트 내 기능을 이끌어내는 것입니다. 특히, ICL에서 제안된 두 가지 설정은 RecSys에 대한 LLM을 프롬프트하는 데 널리 활용됩니다. 하나는 특정 다운스트림 작업의 컨텍스트 및 원하는 완료가 포함된 몇 가지 데모가 프롬프트와 함께 제공되는 few-shot 설정입니다. 다른 하나는 제로샷(zero-shot) 설정으로, LLM에 데모가 제공되지 않고 특정 다운스트림 작업에 대한 자연어 설명만 프롬프트에 추가됩니다. 그림 7에서 볼 수 있듯이 권장 작업을 위한 제로샷 ICL 및 퓨샷 ICL의 간략한 템플릿이 제공됩니다.

기존의 많은 연구들은 동일한 추천 과제 하에서 성과를 비교하기 위해 few-shot ICL과 zero-shot ICL 설정을 동시에 고려하고 있습니다. 일반적으로 퓨샷 ICL은 LLM에 추가적인 컨텍스트 내 데모가 제공되기 때문에 제로샷 ICL을 능가할 수 있습니다. 성능 저하에도 불구하고 제로샷 ICL은 컨텍스트 내 데모를 형성하기 위한 작업별 추천 데이터 세트의 요구 사항을 완전히 완화하고 사용자가 LLM에 데모를 제공할 가능성이 없는 대화형 권장 사항과 같은 특정 작업에 적합할 수 있습니다. 예를 들어, Wang et al. [99] 대화형 추천 작업에 대한 텍스트 설명(예: "대화에서 사용자 쿼리를 기반으로 항목 추천")과 다음과 같은 자연어 형식 지침의 두 부분으로 구성된 제로샷 ICL 템플릿을 사용하여 ChatGPT에 대화형 추천을 요청합니다. "출력 형식은 다음과 같아야 합니다. ⟨아니요.⟩ ⟨항목 제목⟩."를 사용하면 권장 사항 결과를 더 쉽게 구문 분석할 수 있습니다.

ICL을 통해 LLM을 추천 작업에 적용하기 위한 간단한 접근 방식은 LLM이 추천자 역할을 하도록 가르치는 것입니다. 예를 들어, Liu et al. [48] ChatGPT를 사용하고 Top-K 추천, 등급 예측, 설명 생성 등 다양한 추천 작업에 맞는 별도의 작업 설명을 제안하여 각 추천 작업의 해당 입출력 예시를 기반으로 ICL을 수행합니다. 예를 들어 사용자 평점 기록은 평점 예측 작업의 예로 제공됩니다. 마찬가지로, 기존의 다른 작업들은 더 나은 추천 성능을 위해 상황에 맞는 데모를 설계하는 데 대한 뚜렷한 통찰력을 제공합니다. 예를 들어, "당신은 도서 등급 전문가입니다."와 같은 역할 주입에 대한 텍스트 설명은 [67] 컨텍스트 내 데모를 보강하여 LLM이 추천 작업 완료를 거부하는 것을 방지합니다(예: LLM은 때때로 "As a language model, I don't have the ability to recommend ..."로 응답합니다).

LLM이 RecSys 역할을 직접 하도록 가르치는 것 외에도 ICL은 LLM과 기존 추천 모델을 연결하는 데에도 활용됩니다. 예를 들어 Chat-Rec라는 프레임워크가 있습니다 [3] ICL을 통해 ChatGPT와 기존 RecSys를 연결하는 것이 제안되며, ChatGPT는 기존 RecSys에서 후보 항목을 수신하는 방법을 학습한 다음 최종 추천 결과를 구체화합니다. 더군다나 장 [113] 외부 그래프 추론 도구용 텍스트 API 호출 템플릿을 설계하고 ICL을 통해 해당 템플릿을 사용하여 외부 도구에서 생성된 그래프 기반 추천 결과에 액세스하도록 ChatGPT를 성공적으로 가르칩니다. 최근에는 InteRecAgent와 같은 RecSys에서 사용자 동작을 시뮬레이션하기 위해 LLM 기반 자율 에이전트가 개발되었습니다 [114], RecAgent [115]및 Agent4Rec [116]LLM에 메모리 및 액션 모듈을 장착합니다. 특히, few-show ICL 메서드는 LLM을 이러한 외부 모듈과 연결하여 LLM이 RecSys와 상호 작용하고 채팅 및 게시와 같은 사용자 행동을 시뮬레이션할 수 있도록 설계되었습니다.

그림 7 :추천 작업을 위한 제로샷 ICL 및 퓨샷 ICL의 간략한 템플릿입니다.

5.1.3생각의 사슬(CoT) 프롬프트

ICL은 컨텍스트 내 데모를 통해 다운스트림 작업에 대한 LLM을 유도하는 데 큰 효과를 보였지만 최근 연구에 따르면 LLM은 추론이 많은 작업에서 여전히 제한된 성능을 보입니다 [59]. 좀 더 구체적으로 말하자면, 입력-출력 쌍의 컨텍스트 내 예제를 LLM에 표시하면 LLM이 직접 생성하는 답변이 종종 어려움을 겪습니다 하나 또는 몇 개의 중간 추론 단계 누락 수학 방정식과 같은 다단계 문제에서 후속 추론 단계에서 오류를 유발하는 추론 논리가 손상됨(즉, "1단계 누락 오류" [59]). RecSys에도 대화 권장 사항의 다중 턴 대화 상자를 기반으로 하는 사용자 기본 설정의 다단계 추론과 같은 유사한 다단계 문제가 있습니다. 이러한 한계를 해결하기 위해 CoT는 프롬프트에 중간 추론 단계에 주석을 달아 LLM의 추론 능력을 향상시키는 특별한 프롬프트 전략을 제공합니다. 이를 통해 LLM은 복잡한 의사 결정 프로세스를 세분화하고 단계별 추론을 통해 최종 출력을 생성할 수 있습니다.

복잡한 추론을 통해 LLM을 다양한 다운스트림 작업에 적용하기 위한 적절한 프롬프트 전략을 고려하여, Zhao et al. [19] 제로샷 CoT와 퓨샷 CoT의 두 가지 주요 설정에서 ICL과 CoT 프롬프트의 조합에 대해 논의합니다. 프롬프트에 "단계별로 생각해 봅시다" 및 "그러므로, 답은 다음과 같습니다"와 같은 까다로운 텍스트를 삽입함으로써 제로샷 CoT는 LLM이 작업 관련 지침이나 근거 예제를 제공하지 않고 독립적으로 작업별 추론 단계를 생성하도록 유도합니다. 퓨샷 CoT의 경우, ICL의 각 데모에 대해 작업별 추론 단계가 수동으로 설계되며, 여기서 원래의 입력-출력 예제는 입력-CoT-출력 방식으로 증강됩니다. 또한 CoT는 작업별 지식을 기반으로 추론 단계에 대한 해석 가능한 설명을 추가하여 ICL 데모에서 작업 설명을 보강할 수도 있습니다.

실제로 적절한 CoT 추론 단계의 설계는 특정 권장 작업의 컨텍스트와 목표에 따라 크게 달라집니다. 예를 들어, 간단한 CoT 템플릿 "Please ferer the preference of the user and recommend suitable items."는 LLM이 먼저 사용자의 명시적인 선호도를 추론한 다음 최종 추천을 생성하도록 안내하는 것을 제안합니다 [20]. 아래에서는 전자 상거래 권장 사항의 맥락에서 예를 통해 CoT 프롬프트에 대한 예비 아이디어를 제시합니다.

| [CoT 프롬프트] 사용자 구매 내역을 기반으로 차근차근 생각해 봅시다. 먼저 사용자의 높은 수준의 쇼핑 의도를 유추해 보세요. 둘째, 일반적으로 구매한 품목과 함께 구매하는 품목은 무엇입니까? 마지막으로 쇼핑 의도에 따라 가장 관련성이 높은 품목을 선택하여 사용자에게 추천하십시오. |

최근에는 InteRecAgent와 같은 연구가 있습니다. [114] 및 RecMind [112] CoT 프롬프트를 사용하여 LLM이 에이전트 역할을 하고 외부 도구를 활용하기 위한 계획을 생성하여 복잡한 권장 사항을 하위 작업으로 관리할 수 있도록 했습니다.

RecSys 분야를 넘어 최근 연구 [124] 는 추론 단계를 노드로 모델링하고 추론 경로를 순차적 체인 대신 에지로 연결하여 LLM(특히 T5)의 그래프 추론 기능을 용이하게 하기 위해 CoT 프롬프트를 채택하는 것이 매우 효과적임을 밝혔습니다. 우리는 추천 작업이 그래프 학습에서 링크 예측 문제의 특별한 경우로 간주될 수 있다는 사실에 근거하여 유사한 아이디어가 잠재적으로 이전되어 RecSys에 대한 CoT 프롬프트에 기여할 수 있다고 믿습니다.

5.2프롬프트 튜닝

다운스트림 태스크를 위해 LLM을 수동으로 프롬프트하는 것(예: 자연어로 태스크별 프롬프트를 수동으로 생성)과 달리, 프롬프트 튜닝은 LLM에 새로운 프롬프트 토큰을 추가하고 태스크별 데이터 세트를 기반으로 프롬프트를 최적화하는 추가 프롬프트 기술로 사용됩니다. 일반적으로 프롬프트 튜닝은 특정 작업에 대한 프롬프트를 수동으로 설계하는 것보다 작업별 지식과 인적 노력이 덜 필요하며 조정 가능한 프롬프트와 LLM의 입력 레이어에 대한 최소한의 파라미터 업데이트만 포함합니다. 예를 들어, AutoPrompt [125] prompt를 어휘 토큰 집합으로 분해하고 특정 작업의 성능과 관련하여 그래디언트 기반 검색을 통해 언어 모델에 적합한 토큰을 찾는 단계를 수행합니다.

정의에 따르면, 프롬프트는 불연속적(즉, 하드) 또는 연속적(즉, 소프트)일 수 있으며, LLM이 예상 출력을 생성하도록 안내합니다 [126]. 따라서 아래 그림과 같이 RecSys용 LLM을 프롬프트하기 위한 프롬프트 튜닝 전략을 하드 프롬프트 튜닝과 소프트 프롬프트 튜닝으로 분류합니다.

5.2.1하드 프롬프트 튜닝

하드 프롬프트 튜닝은 LLM을 특정 다운스트림 작업에 프롬프트하기 위해 프롬프트의 개별 텍스트 템플릿(예: 자연어)을 생성하고 업데이트하는 것입니다. 동 외 [126] ICL은 하드 프롬프트 튜닝의 하위 클래스로 간주 될 수 있으며 ICL의 컨텍스트 내 데모를 프롬프트의 일부로 간주 할 수 있다고 주장합니다. 이러한 관점에서 ICL은 작업별 추천 데이터 세트를 기반으로 자연어로 프롬프트를 구체화하여 LLM을 다운스트림 추천 작업에 프롬프트하기 위한 하드 프롬프트 튜닝을 수행합니다. 다운스트림 추천 작업을 위한 자연어 프롬프트를 생성하거나 구체화하는 효과와 편리함에도 불구하고, 하드 프롬프트 튜닝은 특정 추천 작업에 적합한 프롬프트를 찾기 위해 방대한 어휘 공간을 발견하기 위해 힘든 시행착오를 거쳐야 하는 이산 최적화 문제에 직면할 수밖에 없습니다.

5.2.2소프트 프롬프트 튜닝

개별 프롬프트와 달리 소프트 프롬프트 튜닝은 연속 벡터를 프롬프트(예: 텍스트 임베딩)로 사용하고 그래디언트 메서드를 사용하여 권장 사항 손실과 관련하여 프롬프트를 업데이트하는 등 작업별 데이터 세트를 기반으로 프롬프트를 최적화합니다. LLM에서 소프트 프롬프트 토큰은 종종 입력 계층의 원래 입력 토큰(예: 토크나이저)에 연결됩니다. 소프트 프롬프트 튜닝 중에는 LLM의 입력 레이어에 있는 소프트 프롬프트와 최소 파라미터만 업데이트됩니다.

LLM의 추천 성능을 개선하기 위해 일부 기존 작업은 고급 기능 추출 및 표현 학습 방법을 결합하여 RecSys의 작업별 정보를 더 잘 캡처하고 소프트 프롬프트에 포함합니다. 예를 들어, Wu et al. [127] 대조 학습을 적용하여 사용자 표현을 캡처하고 프롬프트 토큰으로 인코딩하고 Wang et al. [72] 및 Guo et al. [128] 도메인 간 권장 사항의 상호 정보를 소프트 프롬프트로 인코딩하는 유사한 아이디어를 공유합니다. 작업별 정보를 소프트 프롬프트에 직접 포함하는 것 외에도 작업별 데이터 세트를 기반으로 소프트 프롬프트를 학습할 수도 있습니다. 예를 들어, T5가 원하는 추천 결과를 생성하도록 안내하기 위해 무작위로 초기화된 소프트 프롬프트가 채택됩니다 [119]여기서 소프트 프롬프트는 T5 출력을 기반으로 하는 권장 사항 손실과 관련하여 엔드 투 엔드 방식으로 최적화됩니다. 하드 프롬프트와 비교할 때 소프트 프롬프트는 연속 공간을 조정하는 데 더 적합하지만 설명 가능성이 떨어집니다 [119]. 즉, "Your task is to recommend ..."와 같은 자연어의 작업별 하드 프롬프트와 비교할 때 특정 다운스트림 작업과 연속 벡터로 작성된 소프트 프롬프트 간의 관계는 사람이 해석할 수 없습니다.

5.3명령어 튜닝

프롬프트 LLM은 보이지 않는 다운스트림 작업에서 놀라운 퓨샷 성능을 보여주었지만, 최근 연구에 따르면 프롬프트 전략은 제로샷 능력이 훨씬 떨어지는 것으로 나타났습니다 [123]. 이러한 한계를 해결하기 위해, 여러 작업별 프롬프트에 대해 LLM을 미세 조정하기 위한 명령어 튜닝이 제안됩니다. 즉, 명령어 조정은 프롬프트 및 사전 학습 미세 조정 패러다임의 기능을 모두 가지고 있습니다. 이를 통해 LLM은 다양한 다운스트림 작업에 대한 지침으로 프롬프트를 정확히 따르는 더 나은 기능을 얻을 수 있으며, 따라서 새로운 작업 지침을 정확하게 따름으로써 보이지 않는 작업에 대한 LLM의 향상된 제로샷 성능에 기여합니다. 명령어 튜닝의 핵심 인사이트는 특정 다운스트림 작업을 해결하는 대신 프롬프트를 작업 지침으로 따르도록 LLM을 훈련시키는 것입니다. 좀 더 구체적으로 말하자면, 인스트럭션 튜닝은 "인스트럭션"(즉, 프롬프트) 생성과 모델 "튜닝"의 두 단계로 나눌 수 있는데, 인스트럭션 튜닝의 간단한 개념은 프롬프트와 미세 조정 LLM의 조합이기 때문입니다.&

- •

명령(프롬프트) 생성 단계. 공식적으로 명령어 조정은 작업 지향 입력(즉, 작업별 데이터 세트를 기반으로 한 작업 설명)과 원하는 대상(즉, 작업별 데이터 세트를 기반으로 한 해당 출력) 쌍으로 구성된 자연어의 명령 기반 프롬프트 형식을 도입합니다. 다운스트림 추천 작업을 위한 LLM의 명령어 튜닝을 고려하여, Zhang et al. [20] 사용자 선호도, 의도 및 작업 양식을 포함한 권장 사항 중심의 지침 템플릿을 제안하며, 이는 다양한 권장 작업에 대한 지침을 생성하기 위한 공통 템플릿 역할을 합니다. 보다 직접적으로, "작업 설명-입력-출력" 형태의 세 부분으로 구성된 지침 템플릿이 사용됩니다. [68, 70] 작업별 권장 사항 데이터 세트를 기반으로 지침을 생성합니다.

- •

RecSys의 텍스트 데이터 외에도 최근 추천 작업을 위한 LLM의 그래프 이해 능력을 향상시키기 위해 명령어 튜닝이 연구되고 있습니다. 특히, Wu et al. [90] 행동 그래프의 노드(예: 후보 항목)와 에지의 경로(예: 항목 간의 관계)를 자연어 설명으로 인코딩하는 LLM 기반 프롬프트 생성자를 제안하며, 이는 이후에 작업별 데이터 세트를 기반으로 LLM 기반 추천자를 조정하는 데 사용됩니다.

6향후의 방향

이 설문 조사에서는 LLM으로 향상된 추천 시스템에 대한 최신 고급 기술을 종합적으로 검토했습니다. 추천 시스템에 대한 LLM의 적용은 아직 초기 단계이기 때문에 여전히 많은 과제가 있으며 이는 기회이기도 합니다. 이 섹션에서는 이 분야의 몇 가지 잠재적인 미래 방향에 대해 논의합니다.

6.1환각 완화

LLM은 다양한 분야에서 사용되지만, 언어 모델이 그럴듯하게 들리지만 실제로는 부정확하거나 입력 데이터에서 참조할 수 없는 출력을 생성하는 '환각' 현상이 중요한 과제입니다 [129, 130]. 예를 들어, 오늘의 뉴스 이벤트를 찾는 시나리오를 고려할 때 LLM은 실제로 존재하지 않는 뉴스를 잘못 추천/생성합니다. 이 문제의 원인은 데이터 세트에 존재하는 소스-참조 발산과 같은 다양하고 신경망 모델의 학습 및 모델링 선택입니다 [131]. 더욱이 환각 문제는 사용자와 사회에 심각한 위협이 되며, 특히 잘못된 정보의 유포가 심각한 실제 결과를 초래할 수 있는 의학적 권고 또는 법률 자문과 같은 고위험 권고 시나리오에서 더욱 그렇습니다. 이러한 문제를 해결하기 위해 RecSys용 LLM의 학습 및 추론 단계에서 사실적 지식 그래프를 보충적 사실적 지식으로 사용하면 환각 문제를 완화할 수 있습니다. 또한 모델의 출력 단계를 면밀히 조사하여 제작된 콘텐츠의 정확성과 사실성을 확인할 수 있습니다.

6.2추천 시스템을 위한 신뢰할 수 있는 대규모 언어 모델

RecSys용 LLM의 개발은 경제적 가치 창출, 시간 및 노력 절감, 사회적 이익 등 인간에게 상당한 이점을 가져다주었습니다. 그러나 RecSys를 위한 이러한 데이터 기반 LLM은 사용자와 사회에 심각한 위협이 될 수도 있습니다 [132, 5, 133], 신뢰할 수 없는 의사 결정, 다양한 소비자 또는 생산자에 대한 불평등한 대우, 투명성 및 설명 가능성 부족, 사용자 정의를 위한 광범위한 개인 데이터 사용으로 인한 개인 정보 보호 문제 등으로 인해 발생합니다. 그 결과, LLM 기반 RecSys 기술에 대한 부정적인 영향을 완화하고 대중의 신뢰를 높이기 위해 RecSys에 대한 LLM의 신뢰성 문제에 대한 우려가 커지고 있습니다. 따라서 RecSys용 LLM은 안전성 및 견고성(Safety&Robustness), 비차별성(Non-discrimination) 및 공정성(Fairness), 설명 가능성(Explainability), 프라이버시(Privacy)를 포함한 가장 중요한 4가지 차원에서 신뢰성을 확보하고자 합니다.

6.2.1안전성 및 견고성

LLM은 다양한 측면에서 추천 시스템을 발전시키는 것으로 입증되었지만, 안전이 중요한 애플리케이션에서 사용의 안전성과 견고성을 손상시킬 수 있는 적대적 섭동(즉, 입력의 사소한 변경)에도 매우 취약합니다 [53, 132]. 노이즈 입력에 대한 이러한 취약성은 불법적인 이익을 얻고 특정 제품에 대한 시장을 조작하는 것과 같은 악의적인 의도로 수행되는 경우가 많습니다 [134, 135, 136, 137]. 따라서 추천 시스템에 대한 LLM의 출력이 LLM의 입력에 약간의 변화가 있을 때 안정적인지 확인하는 것이 중요합니다. 모델 안전성과 견고성을 강화하기 위해 GPT-4는 RLHF(Reinforcement Learning from Human Feedback) 중에 안전 관련 프롬프트를 통합합니다 [138]. 그러나 RLHF 방법은 수동 라벨링을 위해 상당한 수의 전문가가 필요하며, 이는 실제로 실현 가능하지 않을 수 있습니다. 대안 솔루션에는 LLM에 입력하기 전에 추천 작업을 위해 설계된 프롬프트의 자동 사전 처리가 포함될 수 있습니다. 여기에는 악의적인 프롬프트에 대한 사전 처리 또는 유사한 목적을 가진 프롬프트가 동일한 최종 입력을 갖도록 표준화하여 안전성과 견고성을 향상시킬 수 있습니다. 또, 대표적인 기술의 하나로서, 적대적 훈련 [139] LLM 기반 추천 시스템의 견고성을 개선하는 데 사용할 수 있습니다.

6.2.2차별금지&공정성

방대한 데이터 세트에서 훈련된 LLM은 종종 의도치 않게 인간 데이터의 편견과 고정 관념을 학습하고 영속화하며, 이는 나중에 추천 결과에서 드러납니다. 이러한 현상은 고정관념의 전파에서 특정 사용자 그룹에 대한 불공정한 대우에 이르기까지 다양한 부정적인 결과를 초래할 수 있습니다 [2, 140, 141]. 예를 들어, 추천 시스템의 맥락에서 이러한 편향은 차별적 추천으로 나타날 수 있으며, 이러한 학습된 편향을 기반으로 특정 항목이 부당하게 승격되거나 강등될 수 있습니다. 최근에는 FaiRLLM과 같은 몇 가지 연구가 있습니다. [142] 및 UP5 [119] 사용자 측 및 항목 생성 작업에만 초점을 맞추는 LLM에서 가져온 추천 시스템의 공정성 문제를 살펴봅니다. 동시에, Hou et al. [98] LLM에 프롬프트를 표시하여 추천 작업을 조건부 순위 작업으로 공식화하여 항목 측 공정성을 개선하도록 안내합니다. 그러나 RecSys에 대한 LLM의 비차별 및 공정성에 대한 연구는 예비 단계에 있으며 추가 연구가 여전히 필요합니다.

6.2.3설명 가능성

개인 정보 보호 및 보안 고려 사항으로 인해 특정 회사 및 조직은 ChatGPT 및 GPT-4와 같은 고급 LLM을 오픈 소스로 제공하지 않기로 결정했으며, 이는 RecSys용 LLM의 아키텍처와 매개변수가 대중이 복잡한 내부 작업 메커니즘을 이해할 수 있도록 공개적으로 사용할 수 없음을 나타냅니다. 결과적으로, RecSys용 LLM은 '블랙박스'로 취급될 수 있으며, 사용자가 특정 출력 또는 권장 사항이 생성된 이유를 이해하려는 프로세스를 복잡하게 만들 수 있습니다. 최근에는 Bills et al. [143] GPT-4를 사용하여 GPT-2 모델의 뉴런 동작을 설명하는 자연어 설명을 생성해 보세요. 이 연구는 기초적이지만, LLM의 작동 방식을 이해하기 위한 새로운 관점을 제시합니다. 뉴런은 단순한 자연어로는 쉽게 요약할 수 없는 복잡한 행동을 보입니다. 이를 위해 RecSys용 LLM이 어떻게 작동하는지 이해하여 LLM 기반 추천 시스템의 설명 가능성을 높이기 위한 노력이 필요합니다.

6.2.4사생활

개인 정보 보호는 RecSys용 LLM과 관련하여 가장 중요한 관심사입니다. 그 이유는 여러 가지입니다. 한편, 추천 시스템을 위한 LLM의 성공 여부는 소셜 미디어 및 서적과 같은 다양한 출처에서 수집되는 대량의 데이터에 크게 좌우됩니다. 데이터에 포함된 사용자의 민감한 정보(예: 이메일 및 성별)는 예측 성능을 개선하고 개인화된 경험을 제공하기 위해 최신 LLM을 훈련하는 데 사용될 수 있으며, 이는 사용자의 개인 정보 유출 위험을 초래할 수 있습니다. 반면에 이러한 시스템은 개인 선호도, 온라인 행동 및 기타 식별 가능한 정보를 포함한 민감한 사용자 데이터를 처리하는 경우가 많습니다. 제대로 보호하지 않으면 이 데이터가 악용되어 개인 정보 침해로 이어질 수 있습니다. 따라서 이 데이터의 개인 정보 보호 및 보안을 보장하는 것이 중요합니다. Carlini 외 [144] LLM이 텍스트를 생성할 때 일부 사용자의 실제 신원이나 개인 정보를 공개할 수 있음을 보여줍니다. 최근에, Li et al. [145] 사용자가 프롬프트 튜닝을 기반으로 개인 데이터로 LLM을 사용자 지정할 수 있는 RAPT를 도입합니다. RecSys용 LLM에서 사용자 개인 정보를 보호하는 방법에 대한 지침을 제공합니다.

특히, 최근 연합 학습의 발전과 동시에 [146] 추천 시스템에서 데이터 개인 정보 보호를 촉진하기 위해 [147, 148], LLM은 데이터 개인 정보 보호와 연합 학습 간의 상호 작용에 독특한 기회를 가져왔습니다 [149]. 예를 들어, Zhuang et al. [150] LLM을 컨트롤러로 활용하여 분산 장치를 원활하게 연결하는 연합 학습의 기본 모델로서 LLM의 놀라운 기능을 체계적으로 검토합니다. 특히, LLM을 통해 강화되는 확장 가능한 프레임워크는 분산 데이터 소스에서 연합 학습의 가용성을 지원하며, 이를 통해 현지화된 학습 및 데이터 개인 정보 보호를 탈중앙화된 방식으로 지원함으로써 더 많은 개인 정보 보호 추천 시스템을 보장합니다.

6.3추천 시스템을 위한 수직 도메인별 LLM

ChatGPT와 같은 일반 LLM은 강력한 생성 및 추론 기능을 통해 다양한 영역에서 보편적인 도구가 됩니다. 버티컬 도메인별 LLM은 특정 도메인 또는 산업에 맞게 훈련되고 최적화된 LLM입니다. 건강과 같은 [151] 및 금융 [65]. RecSys를 위한 일반적인 LLM과 비교했을 때, 버티컬 도메인별 LLM 기반 RecSys는 특정 도메인의 지식과 기술에 더 중점을 두고 있으며 더 높은 수준의 도메인 전문성과 실용성을 갖추고 있습니다. 관련 없는 정보를 샅샅이 뒤지는 대신 사용자는 자신의 업무나 개인화된 선호도와 직접 일치하는 콘텐츠에 집중할 수 있습니다. 맞춤형 권장 사항을 제공함으로써 RecSys를 위한 수직 도메인별 LLM은 전문가의 시간을 크게 절약할 수 있습니다. 최근에는 기존 작업에서 의료와 같은 광범위한 영역을 포괄하는 수직적 도메인별 LLM을 제시했습니다 [152, 153]법 [154, 155]및 금융 [156]. 구체적으로 훈련된 덕분에 이러한 수직적 도메인별 LLM은 도메인별 지식, 용어 및 컨텍스트를 더 잘 이해하고 처리할 수 있습니다. 그러나 이러한 모델을 학습시키기 위해 방대한 양의 도메인별 데이터가 필요하기 때문에 데이터 수집 및 주석에 상당한 문제가 발생합니다. 따라서 고품질 도메인 데이터 세트를 구성하고 특정 도메인에 적합한 튜닝 전략을 사용하는 것은 RecSys를 위한 수직 도메인별 LLM을 개발하는 데 필요한 단계입니다. 특히, Jin et al. [157] Amazon-M2라는 다국어 데이터 세트를 Amazon의 세션 기반 추천(즉, 사용자의 상호 작용 항목이 포함된 세션)의 새로운 설정으로 제안하고, LLM을 RecSys로 활용하여 다양한 로캘(다국어)의 사용자 세션 그래프에서 제품 제목, 가격 및 설명을 포함한 항목(노드) 속성과 같은 다국어 및 텍스트 데이터가 포함된 세션 그래프에서 학습할 수 있는 기회를 제공합니다.

6.4Users&Items 인덱싱

최근 연구에 따르면 긴 텍스트에서 사용자-항목 상호 작용 정보를 효과적으로 캡처하기 어려울 수 있으므로 RecSys에서 긴 텍스트를 처리할 때 LLM이 제대로 작동하지 않을 수 있습니다 [98]. 반면, 추천 시스템에서 고유한 ID(즉, 개별 ID)를 사용한 사용자-항목 상호 작용(예: 클릭, 좋아요 및 구독)은 풍부한 협업 지식을 포함하고 있으며, 평점 및 리뷰와 같은 명시적 행동뿐만 아니라 검색 기록 또는 구매 데이터와 같은 암시적 행동을 모두 포함하여 사용자 선호도를 이해하고 예측하는 데 크게 기여합니다. InstructRec을 포함한 여러 연구 [20], 팔 [70], GPT4Rec [110] 및 UP5 [119], 사용자-항목 이력 상호작용 정보를 LLM(예: ChatGPT)에 입력된 텍스트 프롬프트로 활용하여 추천을 시도했습니다. 긴 텍스트 문제를 해결하기 위해 한 가지 가능한 해결책은 사용자-항목 상호 작용을 통합하여 공동 지식 학습을 위해 사용자 및 항목 인덱싱을 수행하는 것입니다. 따라서 단순히 텍스트 형식을 사용하여 사용자와 항목을 나타내는 것이 아니라 LLM 기반 추천 시스템을 구축하기 위해 사용자&항목을 인덱싱하는 고급 방법이 필요합니다.

6.5효율성 미세 조정

RecSys에 LLM을 적용할 때 미세 조정은 사전 훈련된 LLM을 영화 추천과 같은 특정 작업이나 도메인에 적용하는 프로세스를 의미합니다 [70] 또는 책 [68]. 이 프로세스를 통해 모델은 사전 학습 중에 학습한 일반적인 언어 이해 기능을 활용하는 동시에 당면한 작업에 대한 지식을 전문화할 수 있습니다. 그러나 미세 조정은 특히 추천 시스템의 매우 큰 모델 및 대규모 데이터 세트의 경우 계산 비용이 많이 들 수 있습니다. 따라서 미세 조정의 효율성을 개선하는 것이 핵심 과제입니다. 이 경우 Fu et al. [158] 기본 모델과 별도로 최적화할 수 있는 작은 플러그인 신경망인 어댑터 모듈을 사용하여 파라미터 효율적인 전이 학습을 달성합니다. 그러나 RecSys에 대한 현재 어댑터 튜닝 기술은 플랫폼 간 이미지 추천과 관련하여 전체 모델 미세 조정보다 약간 뒤쳐져 있습니다. 멀티모달(즉, 텍스트와 이미지 모두) RecSys에 대한 어댑터 튜닝 효과의 탐구는 잠재적인 미래 방향입니다. 또한 대부분의 일반적인 어댑터 튜닝은 실제로 교육 프로세스의 속도를 높이는 데 도움이 되지 않으므로 엔드 투 엔드 교육을 통해 RecSys의 계산 비용과 시간을 줄일 수 있는 효과적인 최적화 기술을 탐색하는 것이 중요합니다.

6.6데이터 증강

추천 시스템 분야의 대부분의 기존 연구는 디지털 플랫폼에서의 사용자 상호 작용 또는 어노테이터 모집을 통한 사용자 행동 데이터 수집을 기반으로 하는 실제 데이터 기반 연구에 의존합니다. 그럼에도 불구하고 이러한 접근 방식은 리소스 집약적인 것으로 보이며 장기적으로 지속 가능하지 않을 수 있습니다. 입력 데이터의 품질과 다양성은 모델의 성능과 다양성에 직접적인 영향을 미칩니다. 실제 데이터 중심 연구의 단점을 극복하기 위해 Wang et al. [115] LLM 기반의 추천 시스템을 위한 시뮬레이션 패러다임인 RecAgent를 소개하며, 여기에는 소셜 미디어에서 탐색 및 커뮤니케이션을 위한 사용자 모듈과 검색 또는 추천 목록을 제공하기 위한 추천 모듈이 포함됩니다. 또한, LLM-Rec [109] 개인화된 콘텐츠 추천을 개선하기 위해 4가지 프롬프트 전략을 통합하며, 다양한 프롬프트 및 입력 증강 기술이 추천 성능을 향상시킬 수 있음을 실험을 통해 보여줍니다. 따라서 LLM을 추천 시스템으로만 배치하는 것이 아니라 데이터 증강에 활용하여 추천을 강화하는 것이 향후 유망한 전략으로 떠오를 것입니다.

7결론

가장 진보된 AI 기술 중 하나인 LLM은 언어 이해 및 생성에 대한 놀라운 능력, 강력한 일반화 및 추론 기술, 새로운 작업 및 다양한 영역에 대한 신속한 적응 덕분에 분자 발견 및 금융과 같은 다양한 응용 분야에서 큰 성공을 거두었습니다. 마찬가지로, LLM을 통해 추천 시스템을 혁신하여 고품질의 개인화된 제안 서비스를 제공하기 위한 노력이 증가하고 있습니다. 추천 시스템에서 이 연구 주제가 빠르게 발전함에 따라 기존 LLM 기반 추천 시스템을 포괄적으로 요약하는 체계적인 개요가 절실히 필요합니다. 그 간극을 메우기 위해, 이 설문조사에서는 LLM이 적용된 RecSys에 대한 포괄적인 개요를 제공했습니다. 사전 교육미세 조정& 패러다임을 촉구하여 관련 분야의 연구자와 실무자에게 심층적인 이해를 제공합니다. 그럼에도 불구하고 RecSys의 LLM에 대한 현재 연구는 아직 초기 단계에 머물러 있어 이 분야의 LLM에 대한 보다 체계적이고 포괄적인 연구가 필요합니다. 따라서 우리는 이 분야의 잠재적인 미래 방향에 대해서도 논의했습니다.

'논문&아티클 리뷰(LLM + RS)' 카테고리의 다른 글

| 구글 I/O - 2024년 5월 15일 (0) | 2024.05.16 |

|---|---|

| 프롬프트 엔지니어링 방법 (0) | 2024.05.08 |

| Two-Tower Networks and Negative Sampling in Recommender Systems (0) | 2024.05.07 |

| ReAct: 언어 모델에서 추론과 행동의 시너지 효과 (0) | 2024.05.07 |

| A Large Language Model Enhanced ConversationalRecommender System (2) | 2024.05.01 |