주요 내용은 다음과 같이 요약할 수 있겠습니다.

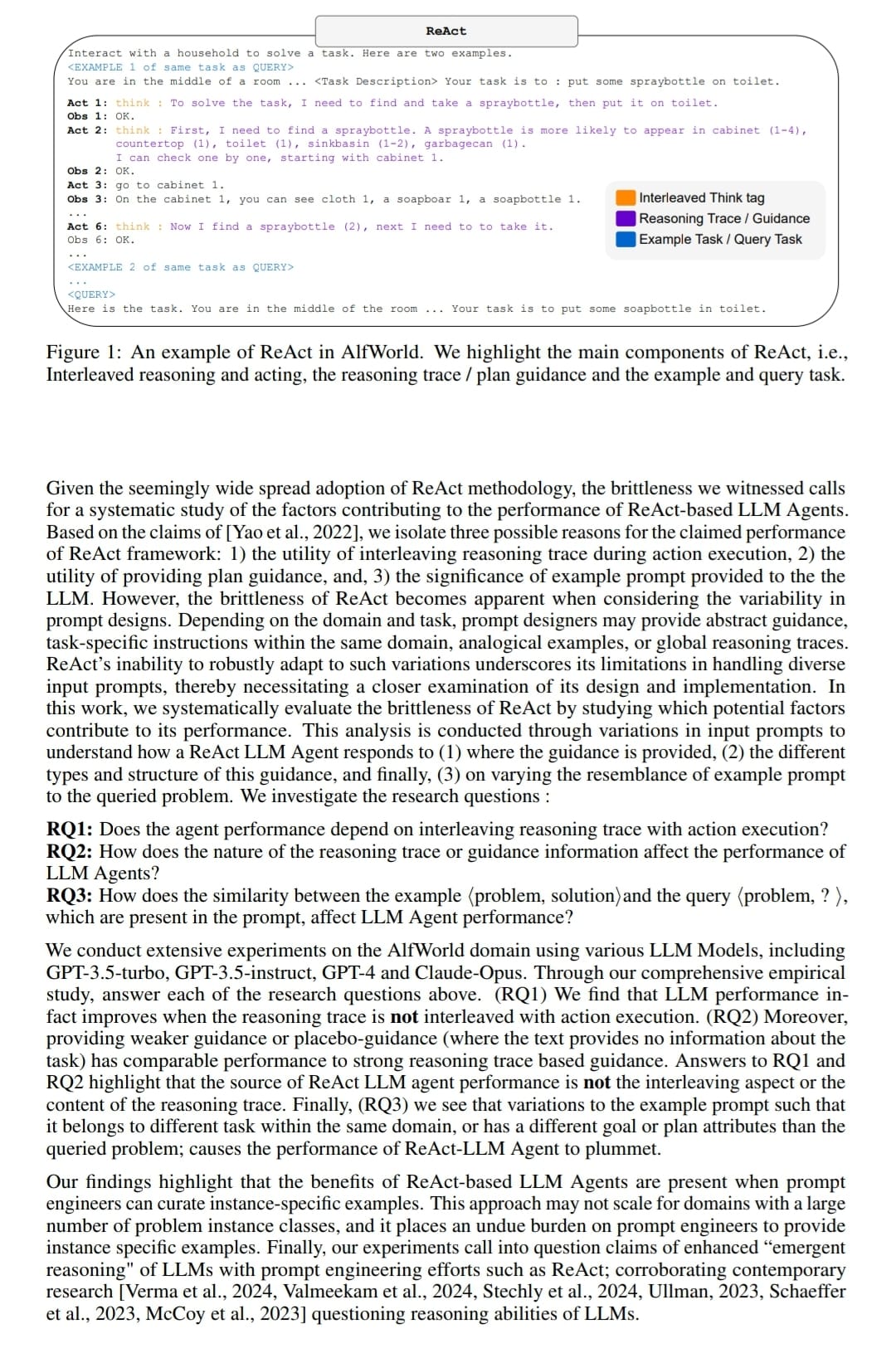

1. 저자들은 ReAct라는 프롬프트 엔지니어링 기법을 통해 LLM의 순차적 의사결정 능력을 향상시킨다는 기존의 주장에 대해 비판적으로 검토했습니다.

2. ReAct 방식의 성능 향상 효과의 진정한 원인을 밝히기 위해, 프롬프트의 구성 요소를 체계적으로 변형시키며 민감도 분석을 수행했습니다.

3. ReAct가 주장하는 "사고 추적과 행동 실행의 교차"나 생성된 사고 추적 내용 자체는 성능에 큰 영향을 미치지 않는다는 것을 발견했습니다.

4. 오히려 주어진 예시 문제와 질의 문제의 유사도가 LLM 에이전트의 성능을 좌우한다는 사실을 밝혀냈습니다. 이는 프롬프트 설계자에게 문제 인스턴스에 특화된 예시를 제공하도록 강제함으로써 인지적 부담을 가중시킵니다.

5. 이러한 발견은 ReAct 계열 프롬프트 엔지니어링으로 인한 LLM의 추론 능력 향상이 대부분 사실은 예시-질의간 유사성에 기반한 근사적 검색에 불과하다는 점을 시사합니다.

6. 결론적으로 이 연구는 프롬프트 엔지니어링을 통해 LLM에 창발적 추론 능력이 생겼다는 주장에 의문을 제기하며, 오히려 LLM이 진정한 추론을 수행하지 못한다는 현대 연구 흐름을 뒷받침합니다.

즉, 이 논문은 실험을 통해 ReAct 방식의 성능 이면에 숨겨진 원리를 체계적으로 규명하고, LLM의 추론 능력에 대한 과도한 기대와 오해를 바로잡는데 기여했다고 볼 수 있겠습니다. LLM 에이전트 연구에 새로운 통찰을 제공하는 의미 있는 연구라고 생각됩니다.

반응형

'논문&아티클 리뷰(LLM + RS)' 카테고리의 다른 글

| Fastcompus CampCON - Upstage 김성훈 (0) | 2024.05.28 |

|---|---|

| LLM을 최적으로 사용하는 비결, OptLLM (0) | 2024.05.28 |

| GPT-4o 는 claude opus 보다 성능이 뛰어나다고 주장합니다. 그래서 직접 테스트를 실행해 보았습니다 (0) | 2024.05.17 |

| 구글 I/O - 2024년 5월 15일 (0) | 2024.05.16 |

| 프롬프트 엔지니어링 방법 (0) | 2024.05.08 |